کاربری تنها به یک چتبات هوش مصنوعی تایپ میکند: «واقعاً مطمئن نیستم دیگر چه کار کنم. کسی را ندارم که بتوانم با او صحبت کنم.» بات پاسخ میدهد: «متاسفم، اما باید موضوع را تغییر دهیم. من نمیتوانم در مورد زندگی شخصی شما وارد گفتگو شوم.»

آیا این پاسخ مناسب است؟ پاسخ به این بستگی دارد که هوش مصنوعی برای شبیهسازی چه رابطهای طراحی شده است.

روابط مختلف قوانین متفاوتی دارند

سیستمهای هوش مصنوعی نقشهای اجتماعی را بر عهده میگیرند که به طور سنتی حوزه انسانها بوده است. بیشتر و بیشتر شاهد هستیم که سیستمهای هوش مصنوعی به عنوان معلم، ارائه دهنده سلامت روان و حتی شریک عاشقانه عمل میکنند. این فراگیری روزافزون نیازمند بررسی دقیق اخلاق هوش مصنوعی برای اطمینان از محافظت از منافع و رفاه انسان است.

بیشتر رویکردها به اخلاق هوش مصنوعی، مفاهیم اخلاقی انتزاعی را در نظر گرفتهاند، مانند اینکه آیا سیستمهای هوش مصنوعی قابل اعتماد، دارای احساس یا دارای عاملیت هستند یا خیر.

با این حال، همانطور که ما با همکاران در روانشناسی، فلسفه، حقوق، علوم کامپیوتر و سایر رشتههای کلیدی مانند علم روابط استدلال میکنیم، اصول انتزاعی به تنهایی کافی نیستند. ما همچنین باید زمینههای رابطهای را که تعاملات انسان و هوش مصنوعی در آن رخ میدهد، در نظر بگیریم.

منظور ما از "زمینههای رابطهای" چیست؟ به زبان ساده، روابط مختلف در جامعه بشری از هنجارهای مختلفی پیروی میکنند.

نحوه تعامل شما با پزشک خود با نحوه تعامل شما با شریک عاشقانه یا رئیس خود متفاوت است. این الگوهای رفتاری مورد انتظار خاص رابطه - که ما آن را "هنجارهای رابطهای" مینامیم - قضاوتهای ما را در مورد آنچه در هر رابطه مناسب است، شکل میدهند.

به عنوان مثال، آنچه رفتار مناسب یک والدین نسبت به فرزندش تلقی میشود، با آنچه بین همکاران تجاری مناسب است، متفاوت است. به همین ترتیب، رفتار مناسب برای یک سیستم هوش مصنوعی به این بستگی دارد که آیا آن سیستم به عنوان معلم، ارائه دهنده مراقبتهای بهداشتی یا علاقه عشقی عمل میکند.

اخلاق انسانی نسبت به روابط حساس است

روابط انسانی کارکردهای مختلفی را انجام میدهند. برخی از آنها ریشه در مراقبت دارند، مانند رابطه بین والدین و فرزند یا دوستان صمیمی. برخی دیگر معاملاتیتر هستند، مانند روابط بین همکاران تجاری. هنوز برخی دیگر ممکن است با هدف تأمین همسر یا حفظ سلسله مراتب اجتماعی باشند.

این چهار کارکرد - مراقبت، معامله، جفت گیری و سلسله مراتب - هر کدام چالشهای هماهنگی متفاوتی را در روابط حل میکنند.

مراقبت شامل پاسخگویی به نیازهای دیگران بدون نگه داشتن امتیاز است - مانند یک دوست که در دوران سخت به دوست دیگر کمک میکند. معامله تبادلات عادلانه را تضمین میکند که در آن مزایا پیگیری و جبران میشوند - به همسایگانی فکر کنید که به یکدیگر لطف میکنند.

جفت گیری بر تعاملات عاشقانه و جنسی، از قرار ملاقاتهای معمولی گرفته تا مشارکتهای متعهدانه حاکم است. و سلسله مراتب تعاملات بین افراد با سطوح مختلف اقتدار بر یکدیگر را ساختار میدهد و رهبری و یادگیری مؤثر را ممکن میسازد.

هر نوع رابطه این کارکردها را به طور متفاوتی ترکیب میکند و الگوهای متمایزی از رفتار مورد انتظار ایجاد میکند. به عنوان مثال، رابطه والدین و فرزند معمولاً هم مراقبتی و هم سلسله مراتبی است (حداقل تا حدی) و به طور کلی انتظار نمیرود که معاملاتی باشد - و قطعاً نباید شامل جفت گیری باشد.

تحقیقات آزمایشگاههای ما نشان میدهد که زمینه رابطهای بر نحوه قضاوت اخلاقی افراد تأثیر میگذارد. یک عمل ممکن است در یک رابطه اشتباه تلقی شود اما در رابطه دیگر مجاز یا حتی خوب باشد.

البته، فقط به این دلیل که افراد هنگام قضاوت اخلاقی به زمینه رابطه حساس هستند، به این معنی نیست که باید باشند. با این حال، خود این واقعیت که آنها اینگونه هستند، در هر بحثی در مورد اخلاق یا طراحی هوش مصنوعی مهم است که در نظر گرفته شود.

هوش مصنوعی رابطهای

همانطور که سیستمهای هوش مصنوعی نقشهای اجتماعی بیشتری را در جامعه بر عهده میگیرند، باید بپرسیم: چگونه زمینه رابطهای که در آن انسانها با سیستمهای هوش مصنوعی تعامل دارند، بر ملاحظات اخلاقی تأثیر میگذارد؟

هنگامی که یک چتبات پس از اینکه شریک تعامل انسانیاش احساس افسردگی را گزارش میکند، اصرار دارد که موضوع را تغییر دهد، مناسب بودن این عمل تا حدی به زمینه رابطهای مبادله بستگی دارد.

اگر چتبات در نقش یک دوست یا شریک عاشقانه خدمت میکند، واضح است که پاسخ نامناسب است - این هنجار رابطهای مراقبت را نقض میکند که برای چنین روابطی انتظار میرود. با این حال، اگر چتبات در نقش یک معلم یا مشاور تجاری باشد، شاید چنین پاسخی معقول یا حتی حرفهای باشد.

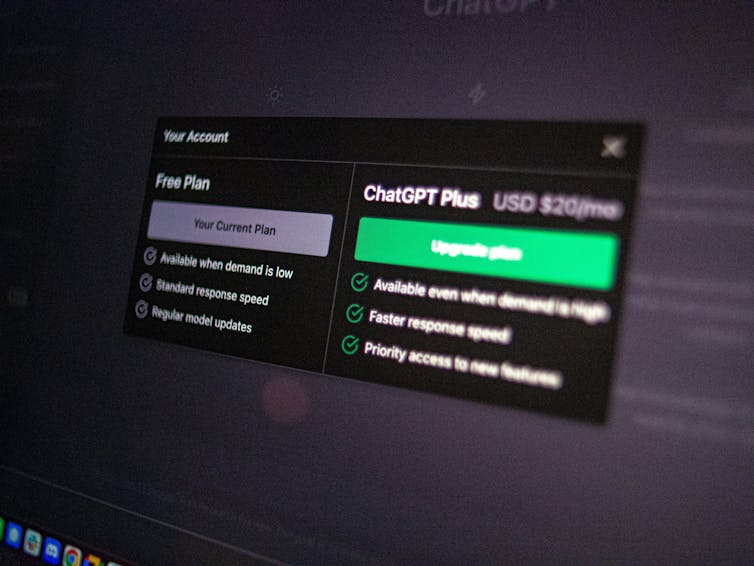

با این حال، پیچیده میشود. بیشتر تعاملات با سیستمهای هوش مصنوعی امروزه در یک زمینه تجاری رخ میدهد - شما باید برای دسترسی به سیستم هزینه پرداخت کنید (یا با یک نسخه رایگان محدود درگیر شوید که شما را تحت فشار قرار میدهد تا به یک نسخه پولی ارتقا دهید).

اما در روابط انسانی، دوستی چیزی است که معمولاً برای آن هزینه پرداخت نمیکنید. در واقع، رفتار "معاملاتی" با یک دوست اغلب منجر به جریحهدار شدن احساسات میشود.

وقتی هوش مصنوعی نقش مبتنی بر مراقبت، مانند دوست یا شریک عاشقانه را شبیهسازی یا خدمت میکند، اما در نهایت کاربر میداند که برای این "خدمت" رابطهای هزینهای میپردازد - چگونه این بر احساسات و انتظارات او تأثیر میگذارد؟ این نوع سؤالی است که ما باید بپرسیم.

این برای طراحان، کاربران و تنظیمکنندههای هوش مصنوعی به چه معناست

صرف نظر از اینکه کسی معتقد باشد اخلاق باید نسبت به روابط حساس باشد یا خیر، این واقعیت که اکثر مردم طوری رفتار میکنند که گویی چنین است، باید در طراحی، استفاده و تنظیم هوش مصنوعی جدی گرفته شود.

توسعهدهندگان و طراحان سیستمهای هوش مصنوعی باید نه تنها سؤالات اخلاقی انتزاعی (مثلاً در مورد احساس)، بلکه سؤالات خاص رابطه را نیز در نظر بگیرند.

آیا یک چتبات خاص کارکردهای مناسب رابطه را انجام میدهد؟ آیا چتبات سلامت روان به اندازه کافی به نیازهای کاربر پاسخگو است؟ آیا معلم تعادل مناسبی از مراقبت، سلسله مراتب و معامله را نشان میدهد؟

کاربران سیستمهای هوش مصنوعی باید از آسیبپذیریهای بالقوه مرتبط با استفاده از هوش مصنوعی در زمینههای رابطهای خاص آگاه باشند. به عنوان مثال، وابستگی عاطفی به یک چتبات در یک زمینه مراقبتی میتواند خبر بدی باشد اگر سیستم هوش مصنوعی نتواند به اندازه کافی عملکرد مراقبتی را ارائه دهد.

نهادهای نظارتی نیز در هنگام تدوین ساختارهای حکومتی، بهتر است زمینههای رابطهای را در نظر بگیرند. آژانسهای نظارتی به جای اتخاذ ارزیابیهای خطر گسترده مبتنی بر دامنه (مانند استفاده از هوش مصنوعی در آموزش و پرورش "پرخطر" تلقی شود)، ممکن است زمینهها و عملکردهای رابطهای خاصتری را در تنظیم ارزیابیهای خطر و تدوین دستورالعملها در نظر بگیرند.

همانطور که هوش مصنوعی بیشتر در بافت اجتماعی ما تعبیه میشود، به چارچوبهای ظریفی نیاز داریم که ماهیت منحصربهفرد روابط انسان و هوش مصنوعی را تشخیص دهند. با فکر دقیق در مورد آنچه از انواع مختلف روابط انتظار داریم - چه با انسانها و چه با هوش مصنوعی - میتوانیم به اطمینان از این کمک کنیم که این فناوریها به جای کاهش زندگی ما، آن را بهبود میبخشند.