به اولین نسخه از خلاصه تحقیق و توسعه رباتیک انویدیا (R2D2) خوش آمدید. این مجموعه وبلاگ فنی به توسعهدهندگان و محققان بینش و دسترسی عمیقتری به آخرین پیشرفتهای تحقیقاتی هوش مصنوعی فیزیکی و رباتیک در آزمایشگاههای تحقیقاتی مختلف انویدیا ارائه میدهد.

توسعه رباتهای مقاوم چالشهای قابل توجهی را به همراه دارد، مانند:

- کمبود داده: تولید دادههای آموزشی متنوع و واقعی برای مدلهای هوش مصنوعی.

- انطباقپذیری: اطمینان از تعمیمپذیری راهکارها در انواع مختلف رباتها و محیطها، و انطباق با محیطهای پویا و غیرقابل پیشبینی.

- یکپارچهسازی: ترکیب مؤثر تحرک، دستکاری، کنترل و استدلال.

ما از طریق تحقیقات پیشرفته که بر روی پلتفرمهایمان تأیید شدهاند، به این چالشها رسیدگی میکنیم. رویکرد ما ترکیبی از تحقیقات پیشرفته با گردشکارهای مهندسی است که بر روی پلتفرمهای هوش مصنوعی و رباتیک ما از جمله NVIDIA Omniverse، Cosmos، Isaac Sim و Isaac Lab آزمایش شدهاند. مدلها، سیاستها و مجموعه دادههای حاصل به عنوان مرجعهای قابل تنظیم برای جامعه تحقیقاتی و توسعهدهندگان عمل میکنند تا با نیازهای خاص رباتیک تطبیق داده شوند. ما مشتاقانه منتظر به اشتراک گذاشتن اکتشافات خود و ساختن آینده رباتیک با هم هستیم.

در این نسخه از R2D2، با گردشکارها و مدلهای زیر برای تحرک ربات و کنترل تمام بدن آشنا خواهید شد و خواهید دید که چگونه آنها چالشهای کلیدی ناوبری، تحرک و کنترل ربات را برطرف میکنند:

- MobilityGen: یک گردشکار مبتنی بر شبیهسازی که از Isaac Sim برای تولید سریع مجموعه دادههای حرکتی مصنوعی بزرگ جهت ساخت مدل برای رباتها در پیکربندیها و محیطهای مختلف استفاده میکند، و همچنین برای آزمایش رباتها جهت ناوبری در محیطهای جدید، هزینهها و زمان را در مقایسه با جمعآوری دادههای واقعی کاهش میدهد.

- COMPASS (سیاست تحرک بین پیکربندیها از طریق یادگیری تقویتی باقیمانده و سنتز مهارت): یک گردشکار برای توسعه سیاستهای تحرک بین پیکربندیها، تسهیل تنظیم دقیق با استفاده از Isaac Lab و استقرار بدون نیاز به آموزش مجدد از شبیهسازی به واقعیت (Zero-shot Sim-to-Real).

- HOVER (کنترلگر همهکاره ربات انساننما): یک گردشکار و یک سیاست عمومی کنترل تمام بدن یکپارچه برای حالتهای کنترلی متنوع در رباتهای انساننما در Isaac Lab.

- ReMEmbR (یک حافظه با بازیابی تقویتشده برای رباتهای تجسمیافته): یک گردشکار که رباتها را قادر میسازد با استفاده از مدلهای زبان بزرگ (LLMs)، مدلهای دیداری-زبانی (VLMs) و تولید تقویتشده با بازیابی (RAG)، استدلال کنند و اقدامات حرکتی انجام دهند.

گردشکارها و مدلهای هوش مصنوعی تحرک ربات انویدیا

رباتهای متحرک، مانند رباتهای انساننما، رباتهای چهارپا و رباتهای متحرک خودکار (AMRs)، به طور فزایندهای در محیطهای متنوع استفاده میشوند و نیازمند سیستمهای ناوبری مقاومی هستند که در هر دو محیط نقشهبرداری شده و ناشناخته به طور ایمن عمل کنند، ضمن اینکه از موانع اجتناب کرده و زمان از کار افتادگی را کاهش دهند. نرمافزارهای ناوبری فعلی با مشکل انطباقپذیری دست و پنجه نرم میکنند، زیرا الگوریتمها بین انواع رباتها (به عنوان مثال، AMRs در مقابل رباتهای انساننما) تفاوت قابل توجهی دارند و برای تغییرات محیطی نیاز به تنظیم دقیق گسترده دارند، که پیچیدگی مهندسی را افزایش داده و مانع از مقیاسپذیری میشود.

تحقیقات انویدیا با توسعه مدلهای پایه سرتاسری مبتنی بر هوش مصنوعی، خطوط لوله تولید داده کارآمد و گردشکارهای آموزشی که استقرار بدون نیاز به آموزش مجدد (Zero-shot) را امکانپذیر میکنند، به این چالشها رسیدگی میکند و به رباتها اجازه میدهد تا در فضاهای شلوغ بدون اتکا به حسگرهای گرانقیمت حرکت کنند.

MobilityGen برای تولید داده

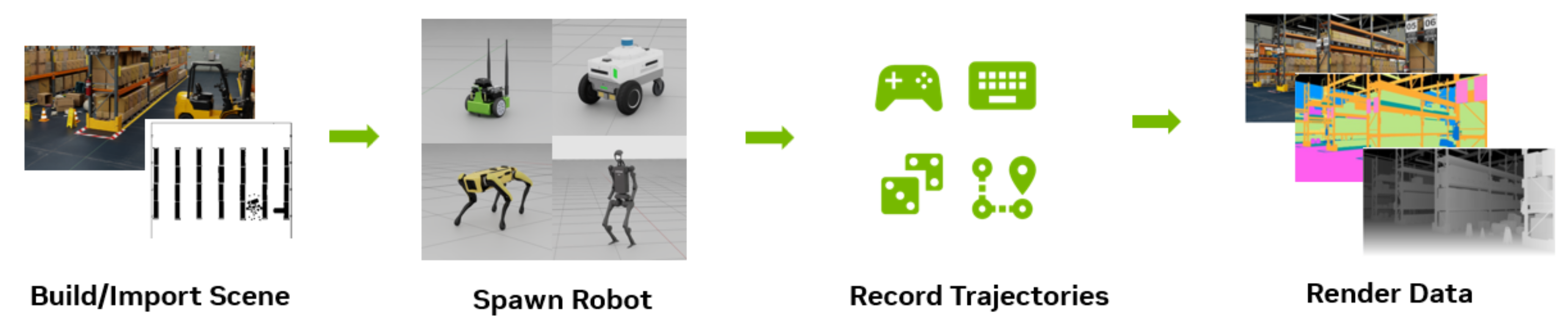

MobilityGen یک گردشکار است که از NVIDIA Isaac Sim برای تولید آسان دادههای حرکتی مصنوعی برای رباتهای متحرک، از جمله رباتهای انساننما، چهارپاها و رباتهای چرخدار استفاده میکند. میتوانید از این دادهها برای آموزش و آزمایش مدلهای تحرک ربات و همچنین الگوریتمهای ادراک استفاده کنید — و مشکل کمبود داده برای آموزش رباتها را حل کنید.

MobilityGen با فعال کردن کاربران برای انجام موارد زیر، به افزودن تنوع به مجموعه دادهها کمک میکند:

- افزودن اشیاء پویا

- افزودن دادههای عمل ربات

- ترکیب نمایشهای انسانی

- افزایش دادهها (به عنوان مثال شرایط نوری)

MobilityGen دادههای زمینی واقعی (ground-truth) را در قالب نقشههای اشغال، اطلاعات وضعیت (pose)، اطلاعات سرعت، تصاویر RGB، عمق و بخشبندی، و دادههای عمل و رندر شده قابل تنظیم ارائه میدهد. این گردشکار از روشهای جمعآوری داده از جمله تلهاپریشن با صفحهکلید یا گیمپد، و اقدامات تصادفی خودکار یا برنامهریزی مسیر قابل تنظیم پشتیبانی میکند.

MobilityGen با مقابله با کمبود داده، پایههای ادراک و تحرک یک پشته رباتیک یکپارچه را تقویت میکند. درباره MobilityGen و نحوه تولید مجموعه داده حرکت و ناوبری برای ربات انساننمای Unitree H1 با استفاده از تلهاپریشن در این دوره رایگان خودآموز مؤسسه یادگیری عمیق (DLI) بیشتر بیاموزید.

COMPASS برای سیاستهای تحرک بین پیکربندیها

COMPASS یک گردشکار برای توسعه سیاستهای تحرک بین پیکربندیها است. این گردشکار یک مدل و گردشکار تحرک سرتاسری قابل تعمیم ارائه میدهد که استقرار بدون نیاز به آموزش مجدد (Zero-shot) از شبیهسازی به واقعیت را در چندین پیکربندی ربات امکانپذیر میکند. هدف این است که مشکل مقیاسپذیری ناشی از چرخههای کند توسعه و آزمایش برای رباتیکدانان حل شود.

COMPASS یادگیری تقلیدی سرتاسری مبتنی بر بینایی (IL) را با X-Mobility، یادگیری تقویتی (RL) باقیمانده در Isaac Lab و روشهای تقطیر سیاست برای مقیاسپذیری در پلتفرمهای مختلف ربات ادغام میکند. در حالی که سیاست X-Mobility مبتنی بر IL بر روی یک پیکربندی خاص از دادههای تولید شده با استفاده از MobilityGen پیشآموزش داده شده است، سیاست عمومی از COMPASS میتواند نرخ موفقیت ۵ برابر بالاتری را برای پیکربندیهای مختلف به دست آورد. این امر رباتهای مختلف را قادر میسازد تا با استفاده از سیاست یکپارچه به طور مؤثر در محیطهای پیچیده حرکت کنند. همچنین به کاربران انعطافپذیری و راحتی برای تنظیم دقیق سیاست برای پیکربندیها و محیطهای خاص میدهد.

مرحله اول گردشکار از مدلسازی جهان با روشهای مبتنی بر IL برای آموزش نمایشی از «عقل سلیم» تحرک برای حالات و اقدامات محیطی استفاده میکند. برخی از نمونههای چنین «عقل سلیمی» عبارتند از درک دینامیک جهان، تشخیص و اجتناب از موانع، برنامهریزی مسیر و آگاهی محیطی.

مرحله دوم از RL باقیمانده برای اصلاح تدریجی سیاست IL از مرحله اول به یک متخصص ویژه پیکربندی استفاده میکند. مرحله سوم از دادههای هر متخصص استفاده کرده و آنها را با استفاده از تقطیر سیاست در یک مدل بین پیکربندیها ادغام میکند. به این ترتیب، تخصص هر متخصص در سیاست تقطیر شده نهایی گنجانده میشود و سازگاری در پلتفرمهای مختلف افزایش مییابد.

COMPASS به تعامل چند رباتی بدون نیاز به آموزش مجدد (Zero-shot) دست مییابد و نشان میدهد که چگونه رباتها در محیطهای مختلف عمل میکنند. همچنین میتوان از آن برای اتصال به یک کنترلگر حرکت-دستکاری (loco-manipulation) برای کارهای مرتبط با حرکت-دستکاری استفاده کرد.

COMPASS با پرداختن به تعمیمپذیری در بین پیکربندیها، پایه تحرک یک پشته رباتیک یکپارچه را تقویت میکند.

HOVER برای کنترل تمام بدن ربات انساننما

تا کنون، ما در مورد سیاستهای تحرک برای قادر ساختن رباتها به حرکت از یک نقطه به موقعیت هدف یاد گرفتهایم. این برای حرکت مقاوم کافی نیست - ما علاوه بر این باید تعادل و کنترل تمام بدن را برای حرکت ایمن و روان فعال کنیم. HOVER با هدف ارائه یک گردشکار مرجع برای این منظور است.

به طور سنتی، رباتهای انساننما برای انجام کارهای متنوع به حالتهای کنترلی مختلفی نیاز دارند، مانند ردیابی سرعت برای ناوبری و ردیابی مفصل بالاتنه برای دستکاری روی میز. HOVER یک گردشکار آموزش داده شده در Isaac Lab است که تمام این حالتهای کنترلی را در یک سیاست یکپارچه برای رباتهای انساننما ادغام میکند. کنترلگرهای دیگر نیز میتوانند به جای HOVER برای رباتها با سایر گردشکارهای توضیح داده شده در این وبلاگ استفاده شوند.

HOVER با ادغام پیچیدگی چندین بخش متحرک یک ربات انساننما در یک کنترلگر عصبی یکپارچه تمام بدن، پایه کنترل یک پشته رباتیک یکپارچه را تقویت میکند. HOVER (کنترلگر همهکاره ربات انساننما) یک چارچوب تقطیر سیاست چند حالته است که حالتهای کنترلی متنوع را در یک سیاست واحد یکپارچه میکند و انتقال یکپارچه بین آنها را امکانپذیر میسازد. یک سیاست پیشگو (oracle policy) برای تقلید دادههای حرکت انسان با استفاده از RL آموزش داده میشود، سپس از یک فرآیند تقطیر سیاست برای انتقال مهارتها از سیاست پیشگو به یک سیاست عمومی استفاده میشود.

کد HOVER همچنین شامل یک نمونه کد استقرار کارآمد برای استفاده در رباتهای Unitree H1 است. این به کاربرانی که به ربات دسترسی دارند امکان میدهد حرکت و پایداری نشان داده شده در شکلهای زیر را تکرار کنند.

ReMEmbR برای استدلال ربات

گردشکارهایی که تاکنون بررسی کردهایم به ایجاد مجموعه داده، سیاستهای تحرک و کنترل تمام بدن برای رباتهای انساننما میپردازند. برای دستیابی به تحرک کاملاً خودمختار با هوش محاورهای، باید استدلال و شناخت ربات را ادغام کنیم. چگونه یک ربات میتواند آنچه را که در یک محیط دیده است به خاطر بسپارد و بر اساس ورودی کاربر، متناسب با آن عمل کند؟

ReMEmbR یک گردشکار است که مدلهای زبان بزرگ (LLMs)، مدلهای دیداری-زبانی (VLMs) و تولید تقویتشده با بازیابی (RAG) را ترکیب میکند تا رباتها را قادر سازد با استفاده از حافظه بلندمدت، استدلال کنند، به سؤالات پاسخ دهند و اقدامات ناوبری را در مناطق بزرگ انجام دهند. این به عنوان یک «حافظه» برای سیستمهای هوش مصنوعی تجسمیافته، مانند رباتهای انساننما، عمل میکند.

گردشکار ReMEmbR ابتدا اطلاعات مربوط به یک محیط را جمعآوری کرده و با استفاده از NVIDIA NeMo Retriever، یک میکروسرویس انویدیا که بخشی از پلتفرم NVIDIA NeMo است و RAG را فعال میکند، آن را در یک پایگاه داده برداری ذخیره میکند. یک VLM تصاویر حاصل از حسگرهای ربات را برای شناسایی اشیاء و مکان آنها تجزیه و تحلیل میکند و شرحهای توصیفی ایجاد میکند که در کنار جاسازیهای تصویر ذخیره میشوند. این اطلاعات نمایه شده و در پایگاه داده برداری ذخیره میشود و حافظه بلندمدت ربات را تشکیل میدهد.

هنگامی که یک پرسش کاربر وارد میشود، ReMEmbR از پایگاه داده برداری برای بازیابی زمینه مرتبط - تصاویر، توضیحات متنی و دادههای مکان - مربوط به پرسش استفاده میکند. سپس LLM از این اطلاعات بازیابی شده، همراه با پرسش اصلی، برای تولید یک پاسخ مستدل و تعیین اقدام مناسب، مانند ناوبری به یک شی یا مکان خاص، استفاده میکند.

ReMEmbR قابلیتهای استدلالی یک پشته رباتیک یکپارچه را افزایش میدهد. این گردشکار مستقل از ربات و محیط است و میتواند برای انواع مختلف رباتها و محیطها اعمال شود، به شرطی که ربات دارای قابلیتهای ناوبری باشد. دمویی از ReMEmbR را در عمل در ویدیوی زیر مشاهده کنید.

همه چیز در کنار هم

گردشکارهای توصیف شده در اینجا، همراه با ابزارهای شبیهسازی و آموزش مانند NVIDIA Isaac Sim و NVIDIA Isaac Lab، راهحلهای جامعی را برای چالشهای کلیدی در تحرک ربات ارائه میدهند: کمبود داده، انطباقپذیری و یکپارچهسازی. این گردشکارها میتوانند به طور یکپارچه ادغام شوند و به طور مستقل برای رفع نیازهای خاص در تحرک ربات استفاده شوند.

با استفاده از MobilityGen، میتوانید مجموعه دادههای مصنوعی را در شبیهسازی تولید کنید تا سیاستهای تحرک خود را آموزش دهید. با استفاده از COMPASS، میتوانید یک سیاست تحرک بین پیکربندیها را توسعه دهید که با انواع مختلف رباتها سازگار است. HOVER یک کنترلگر تمام بدن مقاوم برای رباتهای انساننما است که میتواند با سیاستهای COMPASS برای حرکت و کنترل یکپارچه ترکیب شود. در نهایت، ReMEmbR قابلیتهای استدلال و حافظه بلندمدت را فراهم میکند و رباتها را قادر میسازد تا محیط خود را درک کرده و به دستورات کاربر به طور هوشمند پاسخ دهند.

این گردشکارها در کنار هم یک پشته نرمافزاری قدرتمند برای توسعه رباتهای متحرک مقاوم و هوشمند ارائه میدهند.

شروع کنید

برای شروع با گردشکارها و مدلهای پایه هوش مصنوعی برای تحرک و کنترل ربات، منابع زیر را کاوش کنید:

- درباره MobilityGen بیشتر بیاموزید و با استفاده از این دوره DLI، تولید مجموعه داده برای رباتهای متحرک را تمرین کنید.

- با گردشکار COMPASS برای توسعه سیاستهای تحرک بین پیکربندیها آشنا شوید.

- کد HOVER را برای کنترل تمام بدن ربات انساننما بررسی کنید.

- در مورد ReMEmbR و نحوه فعال کردن استدلال و اقدام ربات با استفاده از هوش مصنوعی مولد بیشتر بخوانید.

- پروژههای خود را با NVIDIA Isaac Sim و NVIDIA Isaac Lab، پلتفرمهای قدرتمند برای شبیهسازی و آموزش رباتیک، تسریع کنید.