مدلهای پایه ویدیو مانند Hunyuan و Wan 2.1، اگرچه قدرتمند هستند، اما آن نوع کنترل دقیقی را که تولید فیلم و تلویزیون (به ویژه تولید جلوههای بصری VFX) نیاز دارد، به کاربران ارائه نمیدهند.

در استودیوهای حرفهای جلوههای بصری، مدلهای متنباز مانند اینها، به همراه مدلهای قدیمیتر مبتنی بر تصویر (به جای ویدیو) مانند Stable Diffusion، Kandinsky و Flux، معمولاً در کنار مجموعهای از ابزارهای پشتیبان استفاده میشوند که خروجی خام آنها را برای پاسخگویی به نیازهای خلاقانه خاص تطبیق میدهند. وقتی کارگردانی میگوید: «عالی به نظر میرسد، اما میتوانیم کمی بیشتر [ن] آن را تغییر دهیم؟» نمیتوانید پاسخ دهید که مدل به اندازه کافی دقیق نیست تا چنین درخواستهایی را برآورده کند.

در عوض، یک تیم VFX هوش مصنوعی از طیف وسیعی از تکنیکهای سنتی گرافیک کامپیوتری (CGI) و ترکیببندی، همراه با رویهها و گردشکارهای سفارشی توسعهیافته در طول زمان، استفاده میکند تا سعی کند مرزهای سنتز ویدیو را کمی فراتر ببرد.

بنابراین، به قیاس، یک مدل پایه ویدیو بسیار شبیه به نصب پیشفرض یک مرورگر وب مانند کروم است؛ کارهای زیادی را به صورت پیشفرض انجام میدهد، اما اگر میخواهید آن را با نیازهای خود تطبیق دهید، به جای اینکه برعکس عمل کنید، به چند افزونه نیاز خواهید داشت.

شیفتگان کنترل

در دنیای سنتز تصویر مبتنی بر مدلهای انتشاری، مهمترین سیستم شخص ثالث از این دست، ControlNet است.

ControlNet تکنیکی برای افزودن کنترل ساختاریافته به مدلهای مولد مبتنی بر انتشار است که به کاربران امکان میدهد تولید تصویر یا ویدیو را با ورودیهای اضافی مانند نقشههای لبه، نقشههای عمق یا اطلاعات ژست هدایت کنند.

به جای تکیه صرف بر اعلانهای متنی، ControlNet شاخههای شبکه عصبی جداگانه یا آداپتورها (adapters) را معرفی میکند که این سیگنالهای شرطیسازی را پردازش میکنند و در عین حال قابلیتهای مولد مدل پایه را حفظ میکنند.

این امر خروجیهای تنظیمشده دقیقی را امکانپذیر میسازد که به مشخصات کاربر نزدیکتر هستند و آن را به ویژه در کاربردهایی که ترکیببندی، ساختار یا کنترل حرکت دقیق مورد نیاز است، مفید میسازد:

با این حال، چارچوبهای مبتنی بر آداپتور از این نوع، به صورت خارجی بر روی مجموعهای از فرآیندهای عصبی عمل میکنند که بسیار درونگرا هستند. این رویکردها دارای چندین نقطه ضعف هستند.

اولاً، آداپتورها به طور مستقل آموزش داده میشوند که منجر به تداخل شاخهها (branch conflicts) هنگام ترکیب چندین آداپتور میشود که میتواند کیفیت تولید را کاهش دهد.

ثانیاً، آنها افزونگی پارامتر (parameter redundancy) را ایجاد میکنند که نیاز به محاسبات و حافظه اضافی برای هر آداپتور دارد و مقیاسپذیری را ناکارآمد میسازد.

ثالثاً، علیرغم انعطافپذیری، آداپتورها اغلب نتایج زیربهینه (sub-optimal) را در مقایسه با مدلهایی تولید میکنند که به طور کامل برای تولید چند شرطی تنظیم دقیق (fine-tuned) شدهاند. این مسائل باعث میشود روشهای مبتنی بر آداپتور برای وظایفی که نیاز به ادغام یکپارچه چندین سیگنال کنترلی دارند، کمتر مؤثر باشند.

در حالت ایدهآل، قابلیتهای ControlNet باید به صورت بومی (natively) در مدل آموزش داده شوند، به روشی ماژولار که بتواند نوآوریهای بعدی و بسیار مورد انتظار مانند تولید همزمان ویدیو/صدا یا قابلیتهای همگامسازی لب بومی (برای صدای خارجی) را در خود جای دهد.

در حال حاضر، هر قطعه عملکرد اضافی یا یک وظیفه پستولید را نشان میدهد یا یک رویه غیر بومی است که باید در میان وزنههای محکم و حساس هر مدل پایهای که بر روی آن عمل میکند، حرکت کند.

FullDiT

در این بنبست، پیشنهاد جدیدی از چین مطرح میشود که سیستمی را ارائه میدهد که در آن معیارهای سبک ControlNet مستقیماً در زمان آموزش در یک مدل ویدیوی مولد گنجانده شدهاند، به جای اینکه به عنوان یک فکر بعدی کنار گذاشته شوند.

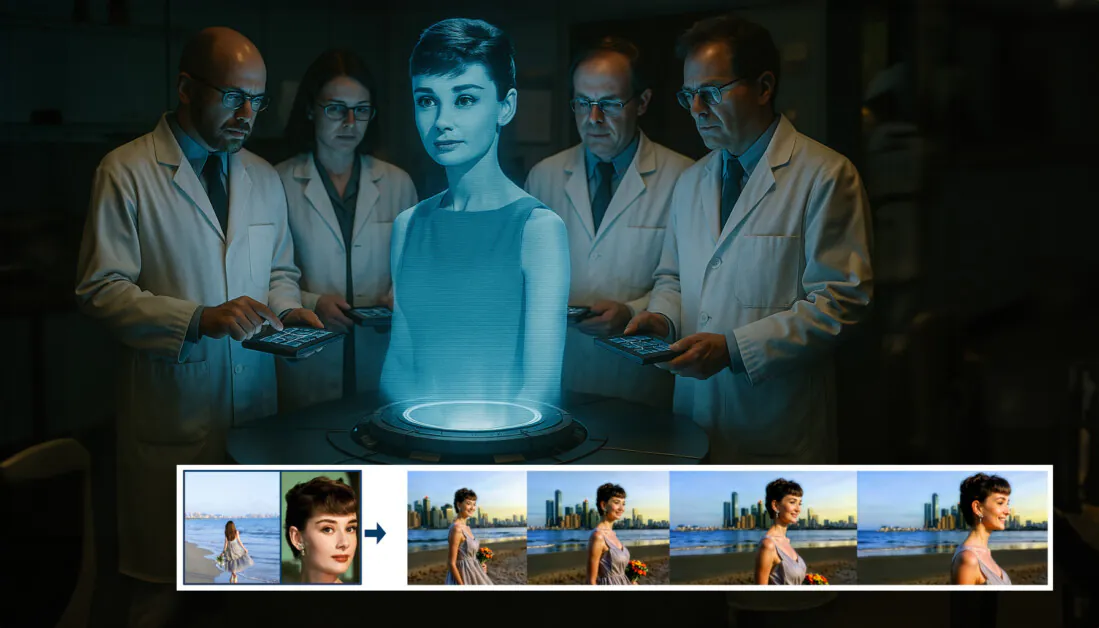

این رویکرد جدید با عنوان FullDiT، شرایط چند وظیفهای مانند انتقال هویت، نقشهبرداری عمق و حرکت دوربین را در بخشی یکپارچه از یک مدل ویدیوی مولد آموزشدیده ادغام میکند که نویسندگان برای آن یک مدل اولیه آموزشدیده و کلیپهای ویدیویی همراه را در وبسایت پروژه تولید کردهاند.

در مثال زیر، تولیدهایی را میبینیم که حرکت دوربین، اطلاعات هویت و اطلاعات متنی (یعنی اعلانهای متنی راهنمای کاربر) را در خود جای دادهاند:

برای پخش کلیک کنید. نمونههایی از تحمیل کاربر به سبک ControlNet تنها با یک مدل پایه آموزشدیده بومی. منبع: https://fulldit.github.io/

لازم به ذکر است که نویسندگان مدل تجربی خود را به عنوان یک مدل پایه کاربردی پیشنهاد نمیکنند، بلکه به عنوان اثبات مفهومی برای مدلهای بومی متن به ویدیو (T2V) و تصویر به ویدیو (I2V) ارائه میدهند که کنترل بیشتری نسبت به فقط یک اعلان تصویر یا یک اعلان متنی به کاربران ارائه میدهند.

از آنجایی که هنوز مدلهای مشابهی از این نوع وجود ندارد، محققان معیار جدیدی با عنوان FullBench برای ارزیابی ویدیوهای چند وظیفهای ایجاد کردند و ادعا میکنند که در آزمایشهای مشابهی که در برابر رویکردهای قبلی طراحی کردهاند، عملکرد پیشرفتهای دارند. با این حال، از آنجایی که FullBench توسط خود نویسندگان طراحی شده است، عینیت آن آزمایش نشده است و مجموعه داده آن با 1400 مورد ممکن است برای نتیجهگیریهای گستردهتر بسیار محدود باشد.

یکپارچگی بومی

نویسندگان FullDiT بر بهبود قابل توجهی در کارایی پارامتر تأکید میکنند. با یکپارچهسازی شرایط کنترلی متعدد در یک معماری واحد، FullDiT به پارامترهای کمتری نسبت به روشهای مبتنی بر آداپتور نیاز دارد که برای هر نوع کنترل به آداپتورهای جداگانه متکی هستند. این رویکرد نه تنها حافظه و بار محاسباتی را کاهش میدهد، بلکه با به حداقل رساندن تداخل شاخهها، کیفیت تولید را نیز بهبود میبخشد.

معماری FullDiT بر اساس Transformer انتشار (Diffusion Transformer یا DiT) است که برای جایگزینی ستون فقرات سنتی U-Net در مدلهای انتشار طراحی شده است. این مدل از بلوکهای DiT برای پردازش ورودیها استفاده میکند و شرایط اضافی را از طریق لایههای نرمالسازی تطبیقی (Adaptive Normalization یا AdaLN) ادغام میکند. این ادغام به مدل اجازه میدهد تا سیگنالهای کنترلی مختلف را به طور مؤثر مدیریت کند و تولید ویدیوی با کیفیت بالا و قابل کنترل را امکانپذیر سازد.

این تحقیق شامل آموزش FullDiT بر روی مجموعهای از مجموعه دادههای ویدئویی متنوع، از جمله WebVid-10M، Panda-70M و دادههای ویدئویی با وضوح بالا و کیفیت بالا که به صورت داخلی جمعآوری شدهاند، میشود. فرآیند آموزش در دو مرحله انجام شد: پیشآموزش در مقیاس بزرگ و سپس تنظیم دقیق چند وظیفهای.

در مرحله اول، مدل بر روی WebVid-10M برای قابلیتهای تولید ویدیوی عمومی آموزش داده شد. در مرحله دوم، مدل بر روی مجموعه دادههای تخصصیتر برای انتقال هویت، شرایط عمق و کنترل حرکت دوربین تنظیم دقیق شد.

ارزیابیهای کمی و کیفی نشان میدهد که FullDiT از روشهای مبتنی بر آداپتور و مدلهای پایه فعلی بهتر عمل میکند. FullBench نشان میدهد که FullDiT دقت بالاتری در پایبندی به سیگنالهای کنترلی متعدد و حفظ کیفیت بصری و انسجام زمانی در ویدیوهای تولید شده به دست میآورد.

به ویژه، این مدل در حفظ هویت چهره و انطباق دقیق با نقشههای عمق و مسیرهای حرکت دوربین مشخص شده توسط کاربر، برتری دارد. این قابلیتها گامی مهم به سوی تولید ویدیوی مولد بسیار کنترلشده و قابل اعتماد نشان میدهند.

همانطور که در ابتدای این مقاله اشاره شد، صنعت خلاق به طور گستردهای منتظر جهش بعدی در کنترل تولید ویدیوی هوش مصنوعی است؛ و به نظر میرسد که رویکردی یکپارچه و چندوجهی مانند FullDiT ممکن است یکی از راههای رسیدن به آن باشد.