خلاصه: رقابت در زمینه شتابدهندههای هوش مصنوعی، نوآوری سریعی را در فناوریهای حافظه با پهنای باند بالا ایجاد میکند. در رویداد GTC امسال، غولهای حافظه سامسونگ، SK Hynix و میکرون از نسل بعدی راهکارهای HBM4 و HBM4e خود که در دست تولید هستند، رونمایی کردند.

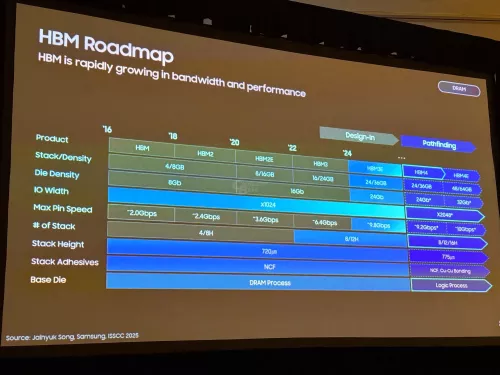

در حالی که پردازندههای گرافیکی مراکز داده در حال انتقال به HBM3e هستند، نقشههای راه حافظه که در Nvidia GTC فاش شد، نشان میدهد که HBM4 گام بزرگ بعدی خواهد بود. Computerbase در این رویداد شرکت کرد و خاطرنشان کرد که این استاندارد جدید امکان بهبودهای جدی در تراکم و پهنای باند را نسبت به HBM3 فراهم میکند.

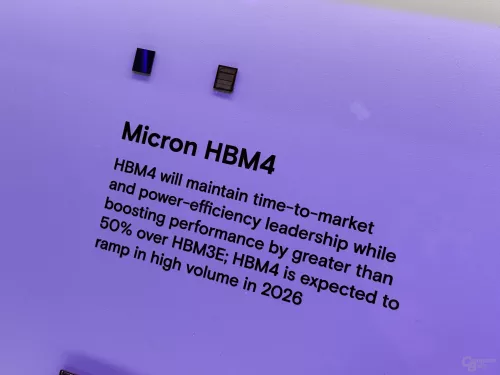

SK Hynix اولین پشته HBM4 خود را با ظرفیت 48 گیگابایت متشکل از 16 لایه تراشه 3 گیگابایتی که با سرعت 8 گیگابیت بر ثانیه کار میکنند، به نمایش گذاشت. به طور مشابه، سامسونگ و میکرون نیز نمایشهای HBM4 با 16 لایه مشابه داشتند و سامسونگ ادعا کرد که سرعتها در نهایت در این نسل به 9.2 گیگابیت بر ثانیه خواهند رسید. انتظار میرود پشتههای 12 لایه 36 گیگابایتی برای محصولات HBM4 که در سال 2026 عرضه میشوند، رایجتر شوند. میکرون میگوید که راهکار HBM4 آن عملکرد را در مقایسه با HBM3e بیش از 50 درصد افزایش میدهد.

با این حال، سازندگان حافظه در حال حاضر فراتر از HBM4 به HBM4e و نقاط ظرفیت خیره کننده نگاه میکنند. نقشه راه سامسونگ خواستار 32 گیگابیت در هر لایه DRAM است که امکان 48 گیگابایت و حتی 64 گیگابایت در هر پشته با نرخ داده بین 9.2 تا 10 گیگابیت بر ثانیه را فراهم میکند. SK Hynix به پشتههای 20 لایه یا بیشتر اشاره کرد که امکان ظرفیتهای تا 64 گیگابایت را با استفاده از تراشههای 3 گیگابایتی خود در HBM4e فراهم میکند.

این تراکمهای بالا برای پردازندههای گرافیکی Rubin آینده Nvidia که هدف آن آموزش هوش مصنوعی است، بسیار مهم است. این شرکت فاش کرد که Rubin Ultra از 16 پشته HBM4e برای 1 ترابایت حافظه عظیم در هر پردازنده گرافیکی هنگام ورود در سال 2027 استفاده خواهد کرد. Nvidia ادعا میکند که با چهار چیپلت در هر بسته و پهنای باند 4.6 پتابایت بر ثانیه، Rubin Ultra امکان 365 ترابایت حافظه ترکیبی را در سیستم NVL576 فراهم میکند.

در حالی که این اعداد چشمگیر هستند، اما با قیمت بسیار بالایی عرضه میشوند. VideoCardz خاطرنشان میکند که به نظر میرسد کارتهای گرافیک مصرفکننده به زودی از انواع HBM استفاده نکنند.

نسل HBM4 و HBM4e یک پل حیاتی برای فعال کردن مقیاسبندی عملکرد مداوم هوش مصنوعی است. اگر سازندگان حافظه بتوانند به نقشههای راه تراکم و پهنای باند تهاجمی خود در چند سال آینده عمل کنند، به طور گستردهای حجم کاری هوش مصنوعی را که به داده نیاز دارد، افزایش میدهد. Nvidia و دیگران روی آن حساب میکنند.

اعتبار تصویر: ComputerBase