شرکت HPC-AI Tech سیستم هوش مصنوعی ویدیویی جدیدی را توسعه داده است که با استفاده از روشهای فشردهسازی جدید، به کیفیت درجه تجاری با حدود یک دهم هزینه آموزش معمول دست مییابد.

در حالی که مدلهای زبانی به طور فزایندهای کارآمدتر شدهاند، هوش مصنوعی ویدیویی همچنان به منابع GPU قابل توجهی نیاز دارد. Open-Sora 2.0 با تبادل مقداری وضوح برای نیازهای محاسباتی بسیار کمتر، رویکرد متفاوتی را در پیش میگیرد.

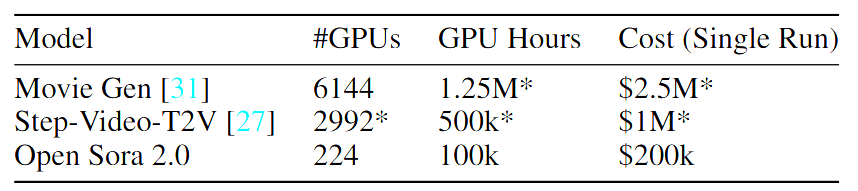

مقاله تحقیقاتی نشان میدهد که هزینههای آموزش تقریباً 200,000 دلار است - تقریباً یک دهم هزینهای که سیستمهایی مانند Movie Gen یا Step-Video-T2V نیاز دارند. آزمایشها نشان میدهد که کیفیت قابل مقایسه با سیستمهای تجاری مانند Runway Gen-3 Alpha و HunyuanVideo است. این تیم از 224 پردازنده گرافیکی Nvidia H200 برای آموزش استفاده کرد.

این سیستم از طریق سه مرحله آموزشی به کارایی خود دست مییابد: با شروع با ویدیوهای با وضوح پایین، تخصص در تبدیل تصویر به ویدیو، و در نهایت تنظیم دقیق برای وضوح بالاتر. این تیم همچنین با گنجاندن مدلهای تصویر از پیش آموزشدیده مانند Flux، منابع را بهینه کرد.

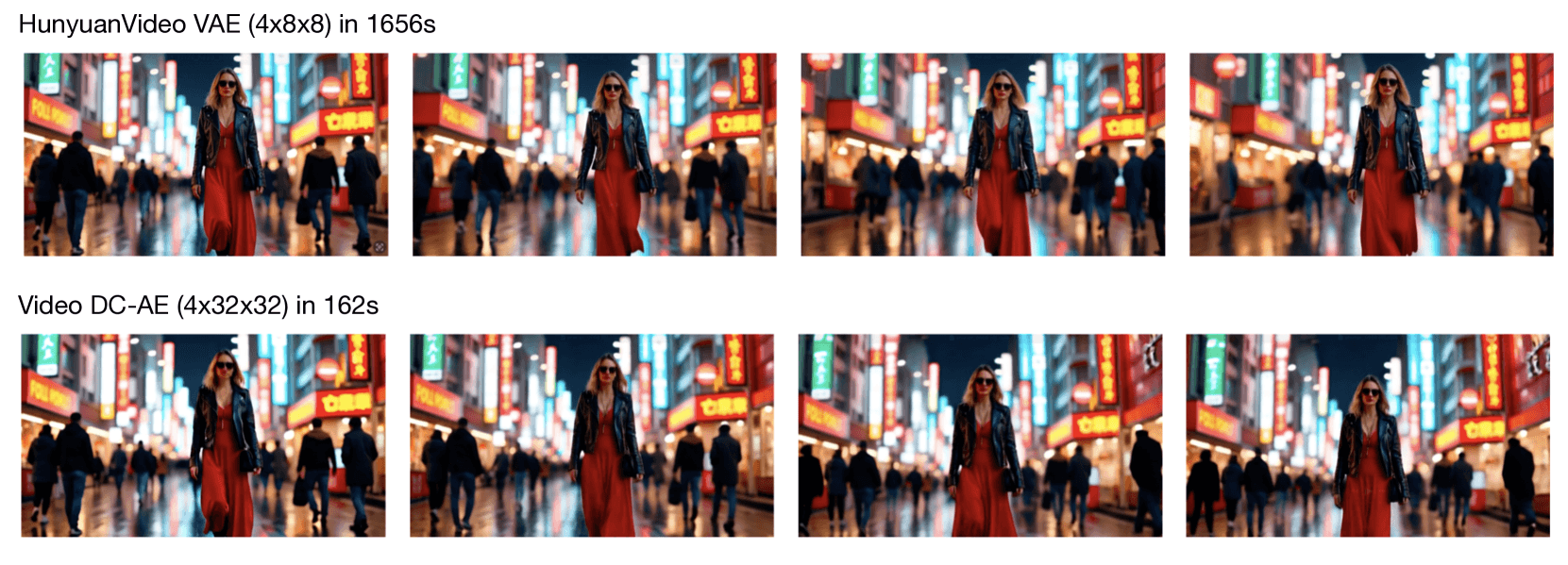

نقطه مرکزی این سیستم، رمزگذار خودکار Video DC-AE است که نرخ فشردهسازی برتری را در مقایسه با روشهای موجود ارائه میدهد. این نوآوری آموزش را 5.2 برابر سریعتر میکند و در عین حال سرعت تولید ویدیو را بیش از ده برابر بهبود میبخشد.

سیستم متنباز هوش مصنوعی ویدیویی تجاری را به چالش میکشد

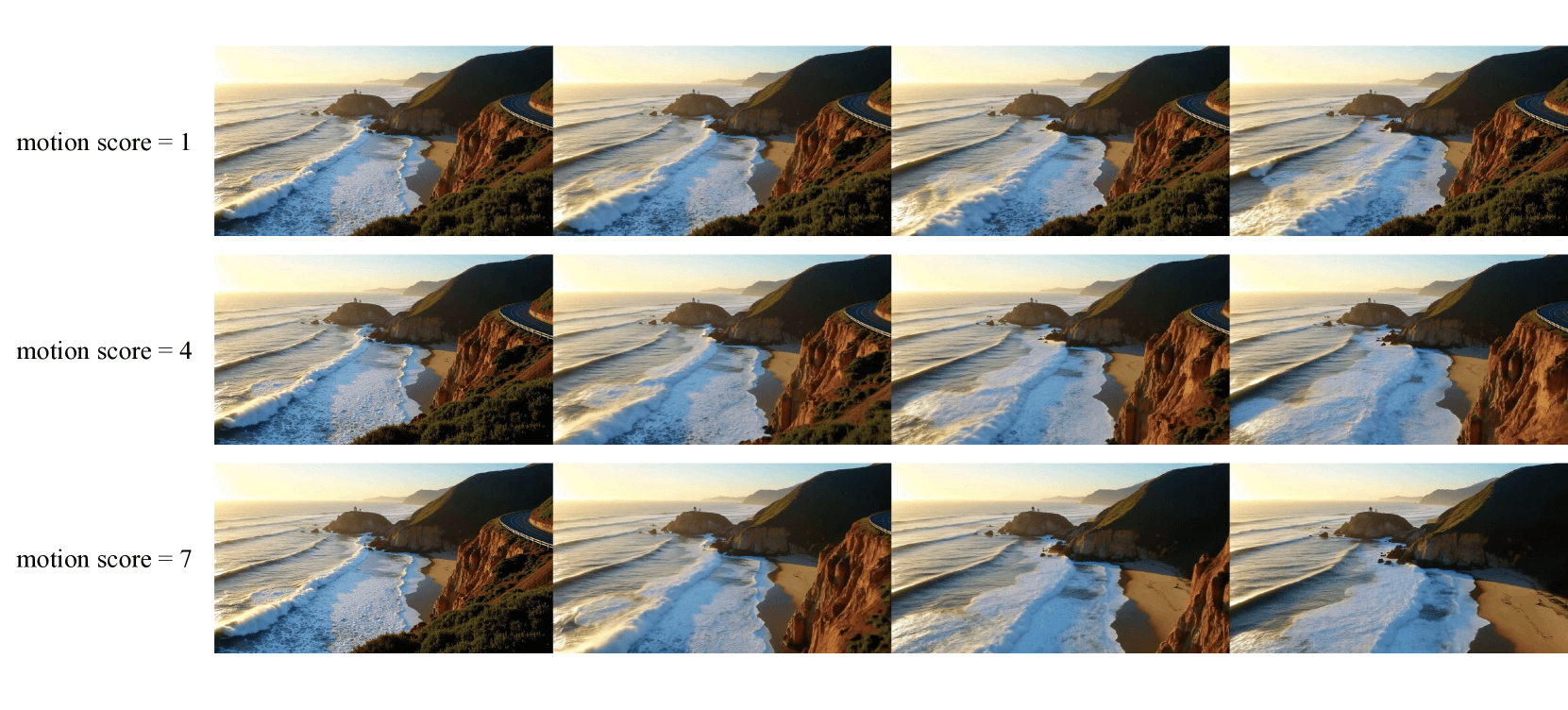

Open-Sora 2.0 میتواند ویدیوها را هم از توضیحات متنی و هم از تصاویر تکی تولید کند. این شامل یک ویژگی امتیاز حرکت است که به کاربران امکان میدهد شدت حرکت را در کلیپهای تولید شده کنترل کنند.

این سیستم محدودیتهای قابل توجهی دارد. ویدیوها فقط میتوانند به وضوح 768x768 پیکسل برسند و حداکثر پنج ثانیه (128 فریم) اجرا شوند. برای مقایسه، Sora OpenAI - که فقط نام خود را با این پروژه به اشتراک میگذارد - میتواند ویدیوهای 1080p را تا 20 ثانیه تولید کند.

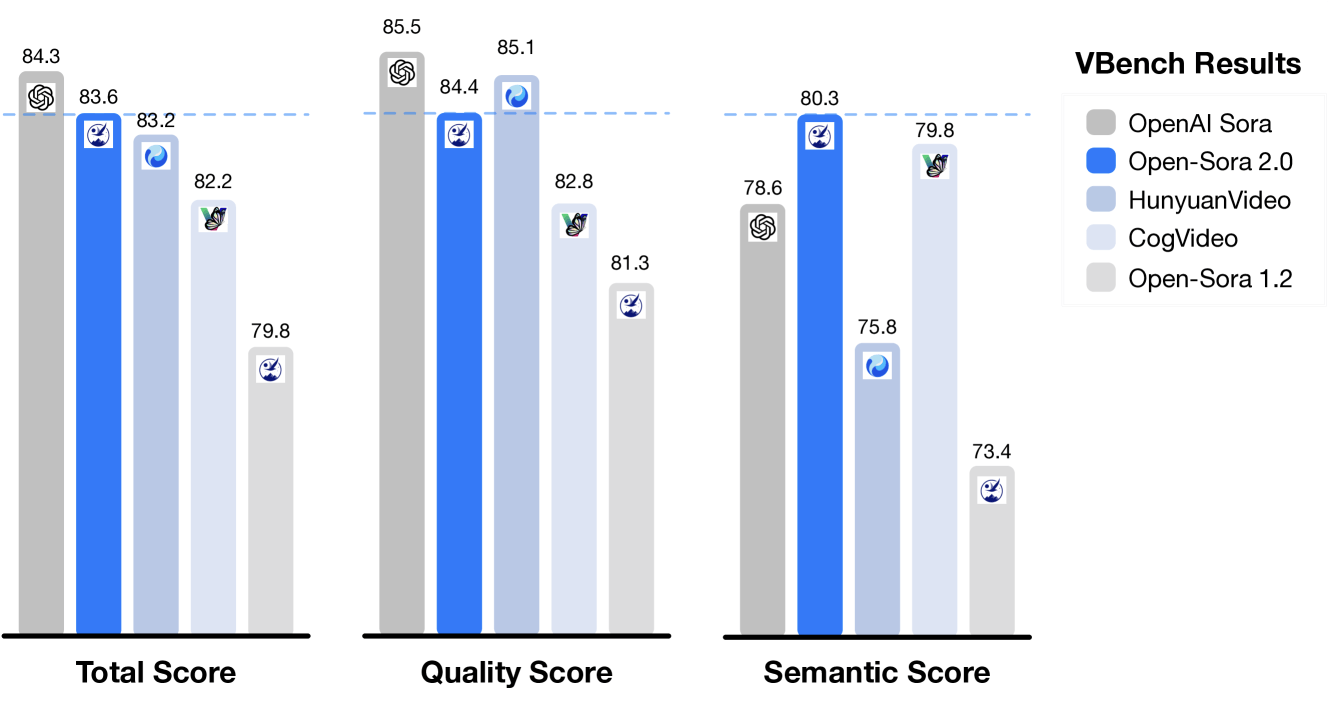

آزمایشها نشان میدهد که این سیستم در معیارهای کلیدی از جمله کیفیت بصری، دقت در درخواست و مدیریت حرکت، در سطوح نزدیک به تجاری عمل میکند. به طور قابل توجهی، امتیاز VBench Open-Sora 2.0 اکنون تنها 0.69 درصد از Sora OpenAI عقبتر است و به طور قابل توجهی شکاف 4.52 درصدی مشاهده شده در نسخه قبلی را کاهش میدهد.

Open-Sora اکنون به عنوان متنباز در GitHub در دسترس است. مانند سایر مدلهای ویدیویی هوش مصنوعی، این مدل نیز هنوز با مصنوعات گاه به گاه و حرکات مغایر با قوانین فیزیک مواجه است. میتوانید نمونههای بیشتری را در صفحه رسمی پروژه تماشا کنید.

تولید ویدیوی هوش مصنوعی به یک زمینه به طور فزاینده رقابتی تبدیل شده است و شرکتهای چینی بخش زیادی از توسعه را رهبری میکنند. سیستمهای جدید تقریباً به صورت هفتگی راهاندازی میشوند، از جمله پروژههای متنباز مانند Genmo Mochi 1 و MiniMax Video-01. در حالی که این مدلها اغلب پیشرفتهای متوسطی در معیارها نشان میدهند، هیچکدام پیشرفت عمدهای در کیفیت کلی ویدیو به دست نیاوردهاند.

استراتژیهای مقرون به صرفه Open-Sora 2.0 جنبههایی از "لحظه Deepseek" در مدلهای زبان را تکرار میکند، زمانی که روشهای آموزشی بهبود یافته به سیستمهای متنباز کمک کرد تا عملکرد سطح تجاری را با هزینههای کاهش یافته به دست آورند. این میتواند بر قیمتگذاری در کل بخش هوش مصنوعی ویدیویی تأثیر بگذارد، جایی که خدماتی مانند آخرین مدل گوگل در حال حاضر به دلیل نیازهای محاسباتی فشرده، 0.50 سنت در ثانیه نیاز دارد.

با این حال، شکاف عملکرد بین هوش مصنوعی ویدیویی متنباز و تجاری همچنان قابل توجهتر از مدلهای زبان است، زیرا حتی رهبران صنعت به کار برای حل چالشهای فنی اساسی ادامه میدهند.