حجم رو به رشد و پیچیدگی دادههای پزشکی—و نیاز مبرم به تشخیص زودهنگام بیماری و بهبود کارایی مراقبتهای بهداشتی—پیشرفتهای بیسابقهای را در هوش مصنوعی پزشکی رقم زده است. از جمله تحولآفرینترین نوآوریها در این زمینه، مدلهای هوش مصنوعی چندوجهی هستند که به طور همزمان متن، تصاویر و ویدئو را پردازش میکنند. این مدلها درک جامعتری از دادههای بیمار نسبت به سیستمهای سنتی تکوجهی ارائه میدهند.

MONAI، سریعترین چارچوب منبع باز در حال رشد برای تصویربرداری پزشکی، در حال تکامل است تا مدلهای چندوجهی قوی را ادغام کند که قرار است گردشهای کاری بالینی و دقت تشخیصی را متحول کند. در طول پنج سال گذشته، MONAI به یک پلتفرم پیشرو در هوش مصنوعی پزشکی و چارچوب بالفعل برای تحقیقات هوش مصنوعی تصویربرداری تبدیل شده است. این پلتفرم بیش از 4.5 میلیون بار دانلود شده و در بیش از 3000 مقاله منتشر شده ظاهر شده است.

این پست توضیح میدهد که چگونه MONAI با استفاده از هوش مصنوعی عامل پیشرفته (استدلال مستقل و مبتنی بر گردش کار) در حال گسترش فراتر از تصویربرداری به یک اکوسیستم چندوجهی است. این اکوسیستم دادههای متنوع مراقبتهای بهداشتی—از سیتی اسکن و امآرآی گرفته تا سوابق الکترونیکی سلامت (EHR) و مستندات بالینی—را ادغام میکند تا توسعه تحقیقات و نوآوری را در حوزههای رادیولوژی، جراحی و آسیبشناسی هدایت کند.

MONAI Multimodal: پل زدن بین سیلوهای دادههای مراقبتهای بهداشتی

با متنوعتر و پیچیدهتر شدن دادههای پزشکی، نیاز به راهحلهای جامعی که منابع داده ناهمگون را متحد کنند، بیش از هر زمان دیگری احساس میشود. MONAI Multimodal نشاندهنده تلاشی متمرکز برای گسترش فراتر از تجزیه و تحلیل تصویربرداری سنتی به یک اکوسیستم تحقیقاتی یکپارچه است. این پلتفرم دادههای متنوع مراقبتهای بهداشتی—از جمله سیتی اسکن، امآرآی، اشعه ایکس، سونوگرافی، سوابق الکترونیکی سلامت، مستندات بالینی، استانداردهای DICOM، جریانهای ویدئویی و تصویربرداری تمام لام (whole slide imaging)—را ترکیب میکند تا تجزیه و تحلیل چندوجهی را برای محققان و توسعهدهندگان امکانپذیر سازد.

بهبودهای کلیدی عبارتند از:

- چارچوب هوش مصنوعی عامل: از عوامل مستقل برای استدلال چند مرحلهای در سراسر تصاویر و متن استفاده میکند.

- مدلهای LLM و VLM تخصصی: مدلهای سفارشیسازی شده برای کاربردهای پزشکی که از ادغام دادههای بینوجهی پشتیبانی میکنند.

- اجزای Data IO: ادغام خوانندههای متنوع Data IO از جمله:

- DICOM برای تصویربرداری پزشکی (به عنوان مثال، سیتی اسکن و امآرآی)

- EHR برای دادههای بالینی ساختاریافته و بدون ساختار

- ویدئو برای ضبطهای جراحی و تصویربرداری پویا

- WSI برای تصاویر پاتولوژی بزرگ و با وضوح بالا

- متن برای یادداشتهای بالینی و سایر دادههای متنی

- تصاویر (PNG، JPEG، BMP) برای اسلایدهای پاتولوژی یا تصاویر ثابت

پلتفرم Monai Multimodal دارای هوش مصنوعی عامل پیشرفته است که از عوامل مستقل برای استدلال چند مرحلهای در سراسر تصاویر و متن و همچنین مدلهای LLM و VLM تخصصی استفاده میکند. این مدلها برای کاربردهای پزشکی طراحی شدهاند و ادغام دادههای بینوجهی را ساده میکنند. این اکوسیستم مشارکتی شامل NVIDIA، مؤسسات تحقیقاتی برتر، سازمانهای مراقبتهای بهداشتی و مراکز دانشگاهی است. این رویکرد یکپارچه با ارائه یک چارچوب سازگار و قابل تکرار برای نوآوری در هوش مصنوعی پزشکی، تحقیقات را تسریع میکند و همکاری بالینی را بهبود میبخشد.

تیم دیر، دکتر رادیولوژیست و شریک مدیریتی در RadImageNet میگوید: «با ادغام جریانهای داده متنوع از طریق مدلهای چندوجهی پیشرفته، ما فقط دقت تشخیصی را بهبود نمیبخشیم—بلکه اساساً نحوه تعامل پزشکان با دادههای بیمار را متحول میکنیم. این نوآوری راه را برای تصمیمگیری سریعتر و مطمئنتر در مراقبتهای بهداشتی هموار میکند.»

بلوکهای سازنده MONAI Multimodal برای یک پلتفرم تحقیقاتی یکپارچه هوش مصنوعی پزشکی چیست؟

به عنوان بخشی از ابتکار گستردهتر، چارچوب MONAI Multimodal شامل چندین جزء اصلی است که برای پشتیبانی از استدلال و ادغام بینوجهی طراحی شدهاند.

چارچوب عامل

چارچوب عامل یک معماری مرجع برای استقرار و سازماندهی عوامل هوش مصنوعی چندوجهی است که استدلال چند مرحلهای را با ادغام دادههای تصویر و متن با منطق انسانمانند امکانپذیر میسازد. این چارچوب از گردشهای کاری سفارشی از طریق پردازش مبتنی بر عامل قابل تنظیم پشتیبانی میکند و با پل زدن بین اجزای بینایی و زبان به آسانی، پیچیدگی ادغام را کاهش میدهد.

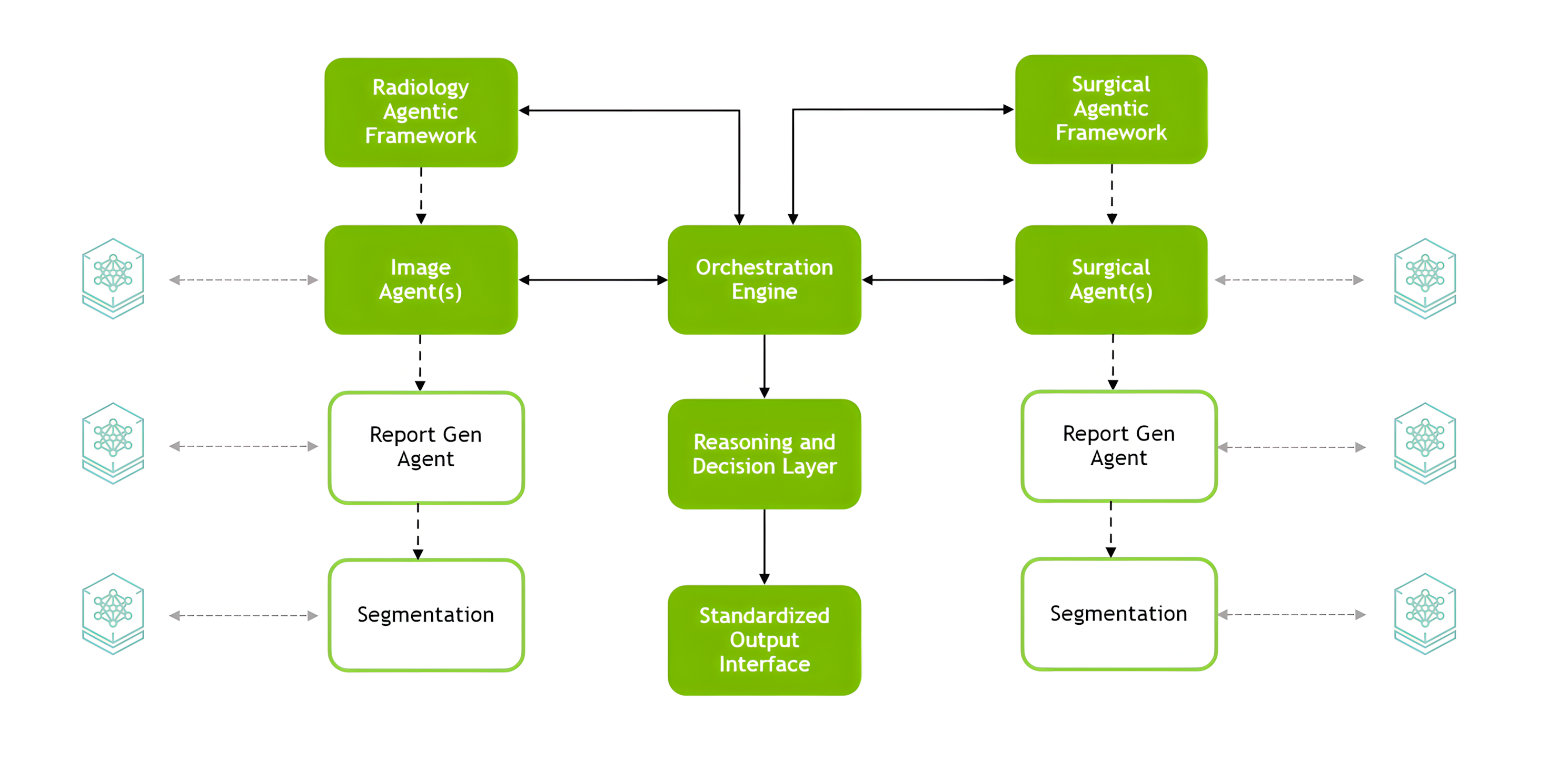

معماری عامل MONAI استدلال بینوجهی را برای هوش مصنوعی پزشکی با استفاده از یک طراحی ماژولار امکانپذیر میکند. این معماری دارای یک موتور ارکستراسیون مرکزی است که عوامل تخصصی را هماهنگ میکند (به عنوان مثال، چارچوب عامل رادیولوژی و چارچوب عامل جراحی)، رابطهایی برای استقرار مداوم و یک لایه استدلال و تصمیمگیری که خروجیهای استاندارد شده را ارائه میدهد (شکل 1).

مدلهای پایه و مشارکتهای جامعه

پلتفرم MONAI Multimodal توسط مجموعهای از مدلهای پیشرفته تغذیه میشود که چارچوبهای تحت رهبری NVIDIA را با نوآوریهای شرکای جامعه ترکیب میکند، همانطور که در زیر شرح داده شده است.

چارچوبهای تحت رهبری NVIDIA

چارچوبهای تحت رهبری NVIDIA شامل موارد زیر است.

چارچوب عامل رادیولوژی (چارچوب عامل رادیولوژی چندوجهی): یک چارچوب عامل متمرکز بر رادیولوژی که تصاویر پزشکی را با دادههای متنی ترکیب میکند تا به رادیولوژیستها در تشخیص و تفسیر کمک کند.

ویژگیهای کلیدی:

- ادغام تصویربرداری سه بعدی CT/MR با دادههای EHR بیمار

- استفاده از مدلهای زبانی بزرگ (LLM) و مدلهای دید زبانی (VLM) برای تجزیه و تحلیل جامع

- دسترسی به مدلهای تخصصی متخصص در صورت تقاضا (VISTA-3D، MONAI BraTS، TorchXRayVision)

- ساخته شده با Meta Llama 3

- پردازش جریانهای داده متعدد برای خروجیهای دقیق

- انجام وظایف استدلال پیچیده با تقسیم مسائل به مراحل قابل مدیریت

چارچوب عامل جراحی (چارچوب عامل جراحی چندوجهی)

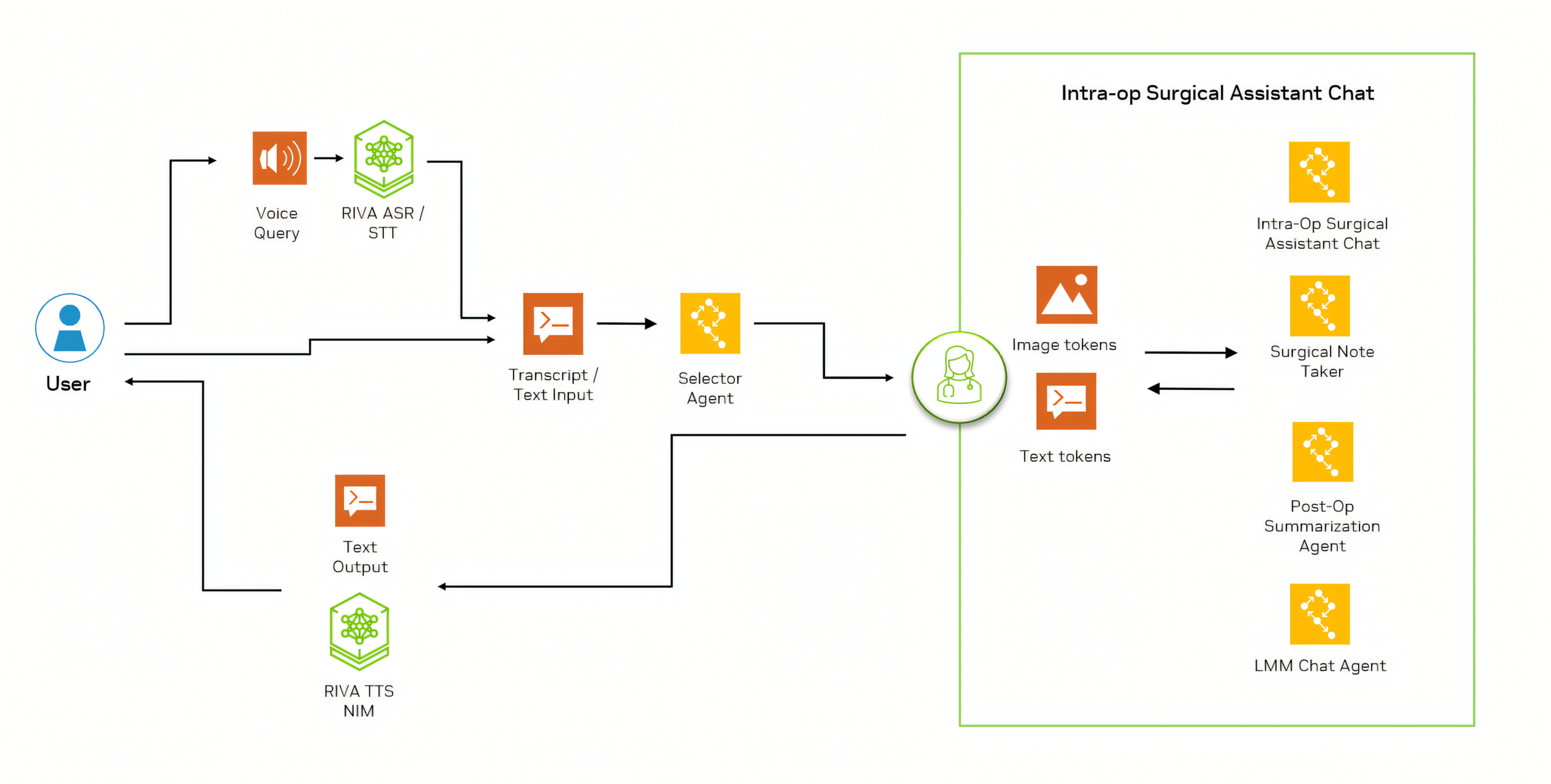

چارچوب عامل جراحی (چارچوب عامل جراحی چندوجهی): ترکیبی سفارشی از VLMها و تولید تقویتشده بازیابی (RAG) که برای کاربردهای جراحی طراحی شده است. این چارچوب پشتیبانی سرتاسری را برای گردشهای کاری جراحی از طریق یک سیستم چند عاملی ارائه میدهد.

ویژگیهای کلیدی:

- رونویسی گفتار در زمان واقعی از طریق Whisper

- عوامل تخصصی برای مسیریابی پرس و جو، پرسش و پاسخ، مستندسازی، حاشیهنویسی و گزارشدهی

- ادغام بینایی کامپیوتر برای تجزیه و تحلیل تصویر

- قابلیتهای پاسخ صوتی اختیاری

- ادغام دادههای قبل از عمل خاص بیمار، ترجیحات پزشک و دانش دستگاه پزشکی

- پردازش دادههای حین عمل در زمان واقعی

- عملکرد به عنوان یک دستیار دیجیتال در تمام مراحل جراحی—آموزش، برنامهریزی، راهنمایی و تجزیه و تحلیل

مدلهای شریک تحت رهبری جامعه

مدلهای شریک تحت رهبری جامعه شامل موارد زیر است.

RadViLLA: RadViLLA که توسط Rad Image Net، مؤسسه مهندسی پزشکی و تصویربرداری زیستی در دانشکده پزشکی ایکان در Mount Sinai و NVIDIA توسعه یافته است، یک VLM سه بعدی برای رادیولوژی است که در پاسخگویی به پرسشهای بالینی برای قفسه سینه، شکم و لگن برتری دارد. RadViLLA روی 75000 سیتی اسکن سه بعدی و بیش از 1 میلیون جفت پرسش و پاسخ تصویری آموزش داده شده است.

این مدل بر روی آناتومیهایی که اغلب تصویربرداری میشوند مانند قفسه سینه، شکم و لگن تمرکز دارد و از یک استراتژی آموزش دو مرحلهای جدید استفاده میکند که سیتی اسکنهای سه بعدی را با دادههای متنی ادغام میکند. RadviLLA به طور مستقل به پرسشهای بالینی پاسخ میدهد و عملکرد برتری را در نمره F1 و دقت متعادل در چندین مجموعه داده نشان میدهد.

CT-CHAT: CT-CHAT که توسط دانشگاه زوریخ توسعه یافته است، یک مدل چت بنیادی دید زبانی پیشرفته است که به طور خاص برای بهبود تفسیر و قابلیتهای تشخیصی تصویربرداری سه بعدی CT قفسه سینه طراحی شده است. این مدل از چارچوب CT-CLIP و یک مجموعه داده پرسش و پاسخ بصری (VQA) که از CT-RATE اقتباس شده است، استفاده میکند.

این مدل که روی بیش از 2.7 میلیون جفت پرسش و پاسخ از CT-RATE آموزش داده شده است، از اطلاعات فضایی سه بعدی استفاده میکند و آن را نسبت به مدلهای مبتنی بر دو بعدی برتر میسازد. CT-CHAT با ترکیب رمزگذار بینایی CT-CLIP با یک مدل زبانی بزرگ از پیش آموزش داده شده، در کاهش زمان تفسیر و ارائه بینشهای تشخیصی دقیق برتری دارد و آن را به ابزاری قدرتمند برای تصویربرداری پزشکی تبدیل میکند.

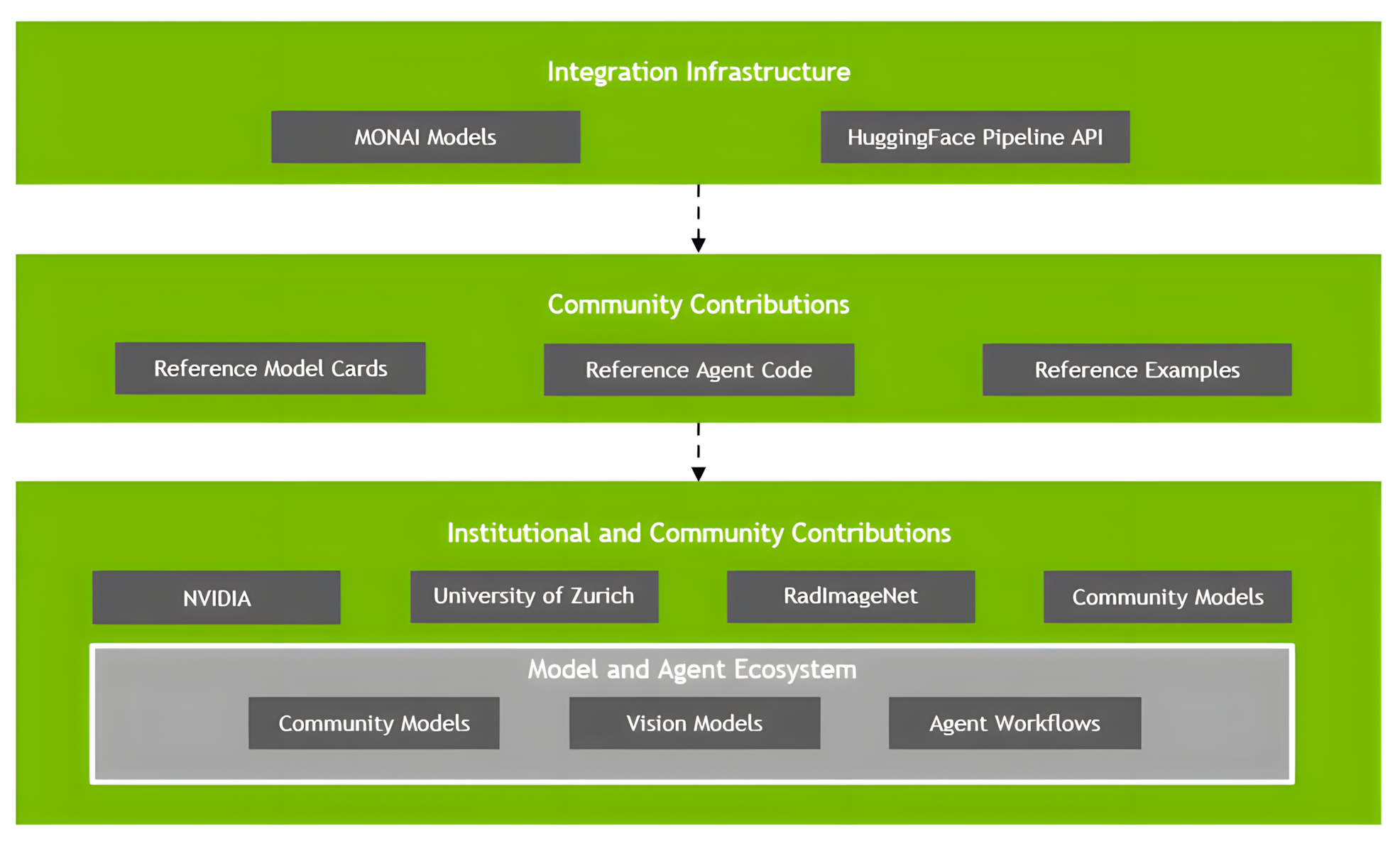

ادغام Hugging Face

پشتیبانی از خط لوله استاندارد شده برای اتصال MONAI Multimodal با زیرساخت تحقیقاتی Hugging Face:

- به اشتراک گذاری مدل برای اهداف تحقیقاتی

- ادغام مدلهای جدید

- مشارکت گستردهتر در اکوسیستم تحقیقاتی

ادغام جامعه

زیرساخت برای به اشتراک گذاری مدل، اعتبارسنجی و توسعه مشارکتی:

- کارتهای مدل استاندارد شده و گردشهای کاری عامل

- تبادل دانش و بهترین شیوههای به اشتراک گذاشته شده

- پایه و اساس برای تحقیقات مشارکتی

آینده هوش مصنوعی پزشکی را با MONAI Multimodal بسازید

MONAI Multimodal نشان دهنده تکامل بعدی MONAI، پلتفرم منبع باز پیشرو برای هوش مصنوعی تصویربرداری پزشکی است. MONAI Multimodal با تکیه بر این پایه، فراتر از تصویربرداری گسترش مییابد تا انواع دادههای متنوع مراقبتهای بهداشتی—از رادیولوژی و آسیبشناسی گرفته تا یادداشتهای بالینی و EHRها—را ادغام کند.

MONAI Multimodal از طریق یک اکوسیستم مشارکتی از چارچوبهای تحت رهبری NVIDIA و مشارکتهای شریک، قابلیتهای استدلال پیشرفته را از طریق معماریهای عامل تخصصی ارائه میدهد. این ابتکار با شکستن سیلوهای داده و امکان تجزیه و تحلیل بینوجهی یکپارچه، چالشهای حیاتی مراقبتهای بهداشتی را در تمام تخصصها برطرف میکند و نوآوری در تحقیقات و ترجمه بالینی را تسریع میکند.

MONAI Multimodal با متحد کردن منابع داده متنوع و استفاده از مدلهای پیشرفته، در حال تحول در مراقبتهای بهداشتی است—و به پزشکان، محققان و نوآوران قدرت میبخشد تا به نتایج چشمگیری در تصویربرداری پزشکی و دقت تشخیصی دست یابند.

ما با هم چیزی فراتر از نرمافزار ایجاد میکنیم—ما در حال ساختن یک اکوسیستم هستیم که در آن نوآوری هوش مصنوعی پزشکی شکوفا میشود و به محققان، پزشکان و بیماران در سراسر جهان سود میرساند. با MONAI شروع کنید.

به ما در NVIDIA GTC 2025 بپیوندید و این جلسات مرتبط را بررسی کنید: