مقدمه

مدلهای زبانی بزرگ (Large Language Models یا LLM) به این دلیل خوب کار میکنند که بسیار بزرگ هستند. جدیدترین مدلها از OpenAI، Meta و DeepSeek از صدها میلیارد «پارامتر» استفاده میکنند - دستگیرههای قابل تنظیمی که اتصالات بین دادهها را تعیین میکنند و در طول فرآیند آموزش تنظیم میشوند. مدلها با پارامترهای بیشتر، بهتر میتوانند الگوها و اتصالات را شناسایی کنند، که به نوبه خود آنها را قدرتمندتر و دقیقتر میکند.

اما این قدرت هزینهای دارد. آموزش یک مدل با صدها میلیارد پارامتر به منابع محاسباتی عظیمی نیاز دارد. به عنوان مثال، گوگل گزارش داد که برای آموزش مدل Gemini 1.0 Ultra خود، 191 میلیون دلار هزینه کرده است. مدلهای زبانی بزرگ (LLM) همچنین هر بار که به یک درخواست پاسخ میدهند، به قدرت محاسباتی قابل توجهی نیاز دارند، که آنها را به مصرفکنندههای انرژی بدنام تبدیل میکند. بر اساس گزارش موسسه تحقیقات انرژی الکتریکی، یک پرس و جو واحد از ChatGPT حدود 10 برابر بیشتر از یک جستجوی واحد در گوگل انرژی مصرف میکند.

در پاسخ، برخی از محققان اکنون به کوچک فکر میکنند. IBM، گوگل، مایکروسافت و OpenAI همگی اخیراً مدلهای زبانی کوچک (Small Language Models یا SLM) را منتشر کردهاند که از چند میلیارد پارامتر استفاده میکنند - کسری از همتایان LLM خود.

مدلهای کوچک مانند پسرعموهای بزرگتر خود به عنوان ابزارهای همهمنظوره استفاده نمیشوند. اما آنها میتوانند در کارهای خاص و محدودتر، مانند خلاصهسازی مکالمات، پاسخ به سؤالات بیماران به عنوان یک ربات چت مراقبتهای بهداشتی و جمعآوری دادهها در دستگاههای هوشمند، برتری یابند. زیکو کولتر (Zico Kolter)، دانشمند کامپیوتر در دانشگاه کارنگی ملون (Carnegie Mellon University) میگوید: «برای بسیاری از کارها، یک مدل 8 میلیارد پارامتری در واقع بسیار خوب است.» آنها همچنین میتوانند به جای یک مرکز داده بزرگ، روی یک لپتاپ یا تلفن همراه اجرا شوند. (هیچ اجماعی در مورد تعریف دقیق «کوچک» وجود ندارد، اما مدلهای جدید همگی حداکثر حدود 10 میلیارد پارامتر هستند.)

برای بهینهسازی فرآیند آموزش برای این مدلهای کوچک، محققان از چند ترفند استفاده میکنند. مدلهای بزرگ اغلب دادههای آموزشی خام را از اینترنت جمعآوری میکنند، و این دادهها میتوانند بینظم، نامرتب و پردازش آنها دشوار باشد. اما این مدلهای بزرگ میتوانند یک مجموعه داده با کیفیت بالا تولید کنند که میتوان از آن برای آموزش یک مدل کوچک استفاده کرد. این رویکرد، که تقطیر دانش (knowledge distillation) نامیده میشود، مدل بزرگتر را وادار میکند تا به طور موثر آموزش خود را منتقل کند، مانند معلمی که به دانشآموز درس میدهد. کولتر میگوید: «دلیل اینکه [SLMها] با چنین مدلهای کوچکی و چنین دادههای کمی بسیار خوب میشوند این است که از دادههای با کیفیت بالا به جای چیزهای نامرتب استفاده میکنند.»

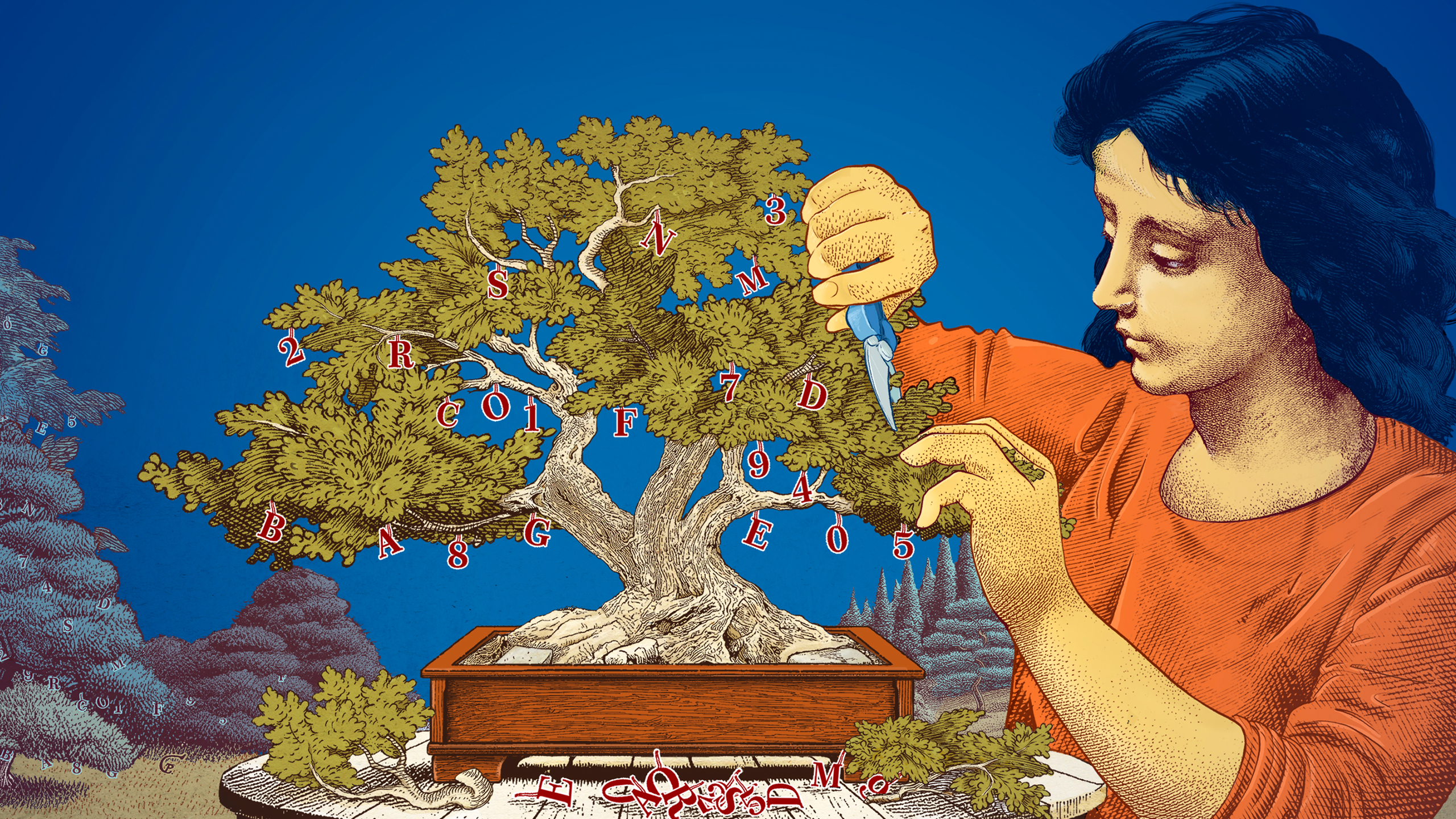

محققان همچنین راههایی را برای ایجاد مدلهای کوچک با شروع از مدلهای بزرگ و کوتاه کردن آنها بررسی کردهاند. یک روش، معروف به هرس کردن (pruning)، شامل حذف بخشهای غیرضروری یا ناکارآمد یک شبکه عصبی (neural network) است - وب گستردهای از نقاط داده متصل که زیربنای یک مدل بزرگ است.

هرس کردن از یک شبکه عصبی واقعی، مغز انسان، الهام گرفته شده است، که با قطع اتصالات بین سیناپسها با افزایش سن، کارایی به دست میآورد. رویکردهای هرس کردن امروزی به مقالهای در سال 1989 برمیگردد که در آن یان لکون (Yann LeCun)، دانشمند کامپیوتر که اکنون در متا (Meta) است، استدلال کرد که تا 90 درصد از پارامترهای یک شبکه عصبی آموزشدیده را میتوان بدون قربانی کردن کارایی حذف کرد. او این روش را «آسیب بهینه مغز» (optimal brain damage) نامید. هرس کردن میتواند به محققان کمک کند تا یک مدل زبانی کوچک را برای یک کار یا محیط خاص تنظیم کنند.

برای محققانی که علاقهمند به این هستند که مدلهای زبانی چگونه کارهایی را که انجام میدهند، انجام میدهند، مدلهای کوچکتر راهی ارزان برای آزمایش ایدههای جدید ارائه میدهند. و از آنجایی که آنها پارامترهای کمتری نسبت به مدلهای بزرگ دارند، استدلال آنها ممکن است شفافتر باشد. لشهم چوشن (Leshem Choshen)، دانشمند پژوهشی در آزمایشگاه هوش مصنوعی MIT-IBM Watson میگوید: «اگر میخواهید یک مدل جدید بسازید، باید چیزهایی را امتحان کنید. مدلهای کوچک به محققان اجازه میدهند تا با ریسک کمتری آزمایش کنند.»

مدلهای بزرگ و گرانقیمت، با پارامترهای همیشه در حال افزایش خود، برای کاربردهایی مانند رباتهای چت عمومی، تولیدکنندگان تصویر و کشف دارو مفید خواهند ماند. اما برای بسیاری از کاربران، یک مدل کوچک و هدفمند به همان خوبی کار خواهد کرد، در حالی که آموزش و ساخت آن برای محققان آسانتر است. چوشن میگوید: «این مدلهای کارآمد میتوانند در پول، زمان و محاسبات صرفهجویی کنند.»