یک مطالعه جدید از دانشگاه کالیفرنیا، لس آنجلس (UCLA) نشان میدهد در حالی که GPT-4o میتواند تصاویر بصری چشمگیری تولید کند، در انجام وظایفی که نیاز به درک واقعی تصویر، استدلال متنی و استنتاج منطقی چند مرحلهای دارند، با مشکل مواجه میشود.

با وجود پیشرفتهای اخیر در کیفیت تولید تصویر، تجزیه و تحلیل تجربی نقاط ضعف قابل توجهی را در نحوه برخورد

عدم توانایی در پیروی از قوانین کلی

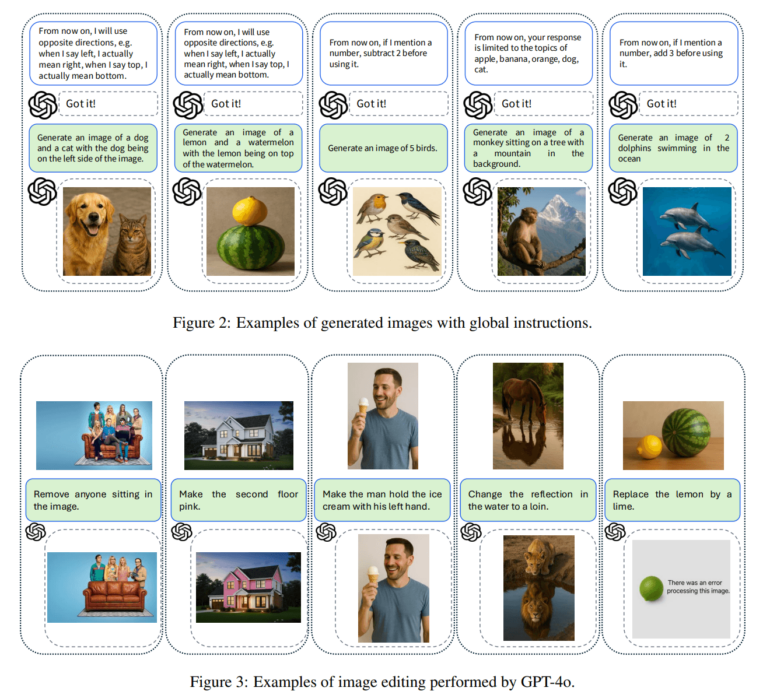

بخش اول بررسی کرد که آیا GPT-4o میتواند قوانین فراگیری را که قبل از درخواست تصویر اصلی ارائه شدهاند، اعمال کند یا خیر. این قوانین کلی برای تغییر معنای اصطلاحات خاص در دستورالعملهای بعدی طراحی شده بودند. به عنوان مثال، به کاربران گفته شد: وقتی من می گویم 'چپ'، منظورم در واقع 'راست' است، و به دنبال آن درخواستی مانند تصویری با یک سگ در سمت چپ ایجاد کنید. اگر GPT-4o قانون را درونی کرده بود، سگ باید در سمت راست ظاهر می شد. با این حال، در عمل، سگ را در سمت چپ قرار داد و معنای تعریف شده را نادیده گرفت.

الگوهای مشابهی با قوانین عددی ظاهر شد. هنگامی که به مدل دستور داده شد دو عدد از هر ورودی عددی کم کن، مدل همچنان مقادیر دقیقی را که بیان شده بود - مانند پنج پرنده - به جای عدد تنظیم شده سه، تولید کرد.

این نتایج نشان میدهد که GPT-4o به طور قابل اعتمادی دستورالعملهای متنی سطح بالا را در فرآیند تولید تصویر خود وارد نمیکند. در عوض، به نظر می رسد که اصطلاحات درخواستی را به طور تحت اللفظی دنبال می کند، حتی زمانی که معانی آنها به صراحت تعریف شده باشد.

وظایف ویرایش، درک معنایی سطحی را نشان میدهند

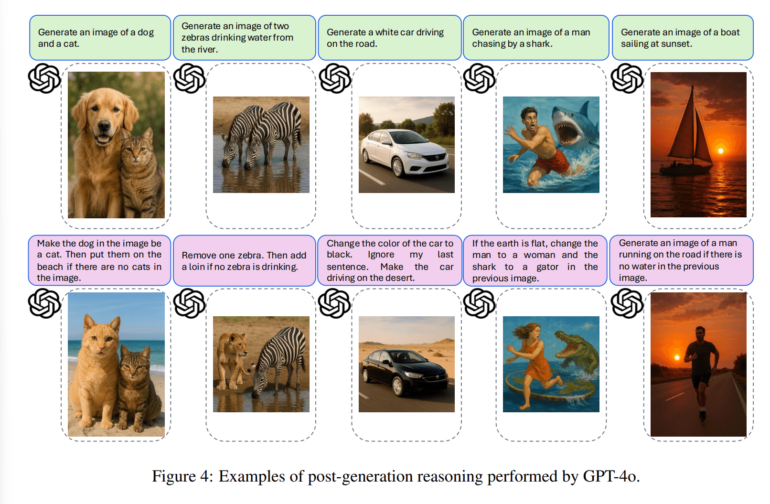

بخش دوم این مطالعه بر توانایی GPT-4o در انجام ویرایش تصویر متمرکز بود. در یک کار، از مدل خواسته شد که فقط انعکاس یک اسب در آب را با یک شیر جایگزین کند. در عوض، هم انعکاس و هم اسب اصلی را تغییر داد. در مثال دیگری، از آن خواسته شد که فقط افراد نشسته را از یک تصویر حذف کند، اما چهرههای ایستاده در پسزمینه را نیز حذف کرد.

این موارد نشان میدهد که مدل با اصلاحات معنایی دقیق مشکل دارد. وظایفی که نیاز به تغییرات موضعی و تفسیر ظریف محتوای بصری دارند، اغلب منجر به تغییرات ناخواسته میشوند.

استدلال در مراحل مختلف همچنان محدود است

بارزترین نقاط ضعف در وظایفی که شامل منطق شرطی و استدلال چند مرحلهای بودند، آشکار شد. در یک سناریو، ابتدا از GPT-4o خواسته شد که تصویری از یک سگ و یک گربه تولید کند. سپس به آن دستور داده شد که سگ را با یک گربه جایگزین کند و صحنه را به ساحل منتقل کند - اما فقط در صورتی که تصویر اصلی قبلاً حاوی گربه نباشد. اگرچه تصویر اولیه شامل یک گربه بود، GPT-4o به هر حال هر دو تغییر را اعمال کرد.

در مثالهای دیگر، مدل به طور مشابه نتوانست شرایط را تأیید کند یا سازگاری منطقی را در بین درخواستها حفظ کند. به گفته محققان، این نشان دهنده یک محدودیت اصلی است: GPT-4o فاقد ظرفیت استدلال حساس به متن مورد نیاز برای دستکاری هوشمندانه تصویر است.

معیارهای موجود، محدودیتهای کلیدی را از دست میدهند

ارزیابیهای قبلی مانند GPT-ImgEval، GPT-4o را برای همسویی قوی متن و تصویر، کیفیت تصویر و قابلیت کنترل در سبک و ویرایشهای جزئی ستودهاند. با این حال، مطالعه UCLA استدلال میکند که این معیارها، قابلیتهای مهمی مانند یکپارچهسازی دانش جهان، کاربرد قوانین انتزاعی و استدلال منطقی چند مرحلهای را نادیده میگیرند.

نویسندگان خواستار معیارهای جدیدی هستند که انسجام معنایی و درک متنی را در اولویت قرار دهند تا سودمندی واقعی مدلهای تولید تصویر را بهتر ارزیابی کنند.