تیمی از دانشگاه مریلند، COLORBENCH را توسعه دادهاند، اولین معیار اختصاصی برای ارزیابی سیستماتیک نحوه درک و پردازش رنگ توسط مدلهای بینایی-زبانی (VLMs).

به گفته محققان، نتایج نشاندهنده نقاط ضعف اساسی در درک رنگ است—حتی در میان بزرگترین مدلهای موجود.

رنگ نقش مهمی در شناخت بصری انسان ایفا میکند و در زمینههایی مانند تصویربرداری پزشکی، سنجش از دور و تشخیص محصول حیاتی است. با این حال، هنوز مشخص نیست که آیا VLMها رنگ را به روشهای قابل مقایسه تفسیر و استفاده میکنند یا خیر.

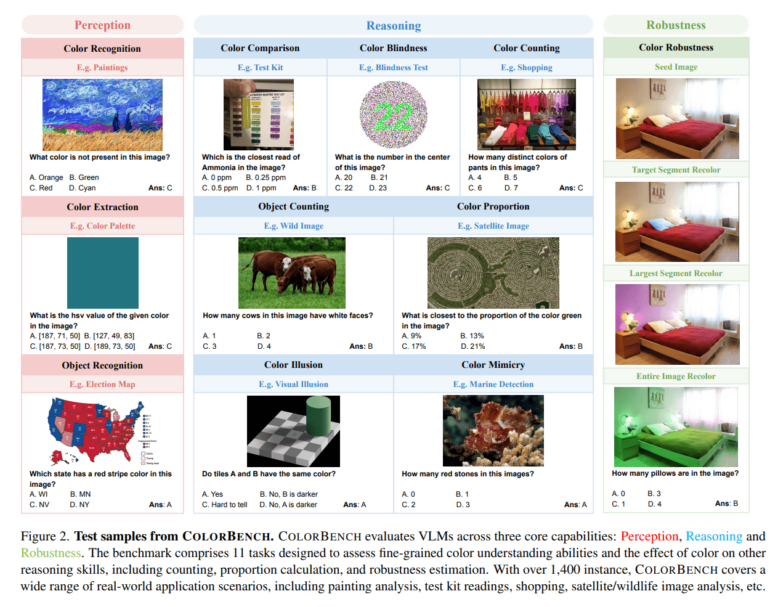

COLORBENCH مدلها را در سه بعد اصلی ارزیابی میکند: درک رنگ، استدلال رنگ و مقاومت در برابر تغییرات رنگ. این معیار شامل ۱۱ کار با مجموع ۱,۴۴۸ نمونه و ۵,۸۱۴ پرسش تصویر-متن است. وظایف نیازمند این است که مدلها رنگها را تشخیص دهند، نسبتهای رنگ را تخمین بزنند، اشیاء با رنگهای خاص را شمارش کنند یا در برابر خطاهای دید رنگی رایج مقاومت کنند. برای مثال، در یک آزمایش، مدلها از نظر سازگاری زمانی که بخشهای خاصی از تصویر از طریق رنگهای مختلف چرخانده میشوند، ارزیابی میشوند.

مدلهای بزرگتر عملکرد بهتری دارند—اما نه خیلی بیشتر

این معیار برای آزمایش ۳۲ VLM پرکاربرد، مانند GPT-4o، Gemini 2 و طیف وسیعی از مدلهای متنباز با حداکثر ۷۸ میلیارد پارامتر استفاده شد. نتایج نشان میدهد که مدلهای بزرگتر عموماً عملکرد بهتری دارند، اما این اثر کمتر از سایر معیارها مشهود است. شکاف عملکرد بین مدلهای متنباز و اختصاصی نیز نسبتاً کوچک است.

همه مدلهای آزمایششده عملکرد ضعیفی در وظایفی مانند شمارش رنگ یا تستهای کوررنگی نشان دادند و اغلب امتیاز زیر ۳۰٪ دقت کسب کردند. حتی در وظایف استخراج رنگ—که از مدلها خواسته میشود مقادیر خاص HSV یا RGB را شناسایی کنند—مدلهای بزرگ معمولاً فقط به امتیازهای متوسط دست یافتند. آنها در وظایف مربوط به تشخیص شی یا رنگ عملکرد بهتری داشتند که محققان آن را به ماهیت دادههای آموزشی نسبت میدهند.

رنگ میتواند مدلها را گمراه کند

یکی از یافتههای کلیدی این است که در حالی که VLMها اغلب به نشانههای رنگی متکی هستند، این سیگنالها گاهی اوقات میتوانند منجر به نتیجهگیریهای نادرست شوند. در وظایف مربوط به خطاهای دید رنگی یا تشخیص اشیاء استتارشده، عملکرد مدل زمانی بهبود یافت که تصاویر به مقیاس خاکستری تبدیل شدند—این نشان میدهد که اطلاعات رنگ در این موارد بیشتر گمراهکننده بوده تا مفید. برعکس، برخی از وظایف بدون رنگ نمیتوانستند بهطور معنیداری انجام شوند.

این مطالعه همچنین نشان داد که استدلال زنجیرهای (CoT) نهتنها عملکرد در وظایف استدلال را افزایش میدهد، بلکه مقاومت در برابر تغییرات رنگ را نیز افزایش میدهد—حتی اگر فقط رنگهای تصویر تغییر کرده باشند، نه سؤالات. برای مثال، با CoT، امتیاز مقاومت GPT-4o از ۴۶.۲٪ به ۶۹.۹٪ افزایش یافت.

مقیاسبندی محدود رمزگذارهای بینایی

محققان مشاهده کردند که عملکرد مدل بیشتر با اندازه مدل زبانی مرتبط است تا با رمزگذار بینایی. بیشتر رمزگذارهای بینایی نسبتاً کوچک باقی میمانند—معمولاً حدود ۳۰۰ تا ۴۰۰ میلیون پارامتر—که توانایی ارزیابی نقش آنها در درک رنگ را محدود میکند. این تیم این را بهعنوان یک محدودیت ساختاری در طراحی فعلی VLM شناسایی میکند و توسعه بیشتر اجزای بصری را توصیه میکند.

خلاصه

- COLORBENCH، یک معیار جدید از دانشگاه مریلند، اولین ابزاری است که به طور سیستماتیک بررسی می کند که مدل های زبان بصری (VLM) چقدر خوب رنگ را درک و تفسیر می کنند و در شرایط متغیر مقاوم می مانند.

- نتایج نشان می دهد که مدل های بزرگتر تمایل به عملکرد بهتری دارند، اما تفاوت بین مدل های منبع باز و اختصاصی کم است.

- این تجزیه و تحلیل همچنین یک نقص ساختاری VLM های فعلی را نشان می دهد: اندازه مدل زبان بیشتر از اندازه رمزگذار بصری با عملکرد همبستگی دارد، که در بسیاری از مدل ها ضعیف مقیاس بندی شده است. محققان توسعه بیشتر اجزای بصری را برای ایجاد VLM های حساس تر به رنگ و قوی تر توصیه می کنند.

منابع: Arxiv